È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate presso www.rsi.ch/ildisinformatico (link diretto) e qui sotto.

Le puntate del Disinformatico sono ascoltabili anche tramite feed RSS, iTunes, Google Podcasts e Spotify.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

---

[CLIP audio: avvio lento di un computer]

Ci si lamenta spesso che i computer e gli smartphone diventano obsoleti nel giro di pochi anni, spingendo a cambiarli spesso, con tutti i costi connessi, e creando tanta spazzatura elettronica, ma ci sono computer la cui vita utile non si misura in anni e neanche in mesi. Si accendono una sola volta, fanno calcoli frenetici per qualche istante, e poi vengono distrutti. Uno spreco incredibile e a prima vista assurdo, ma da questi computer, in un certo senso, dipende la pace nel mondo.

Questa è la storia di HERT, il computer meno longevo di sempre, e delle sue prestazioni incredibili. Non lo troverete nei negozi: noi comuni mortali non possiamo comperarlo, e c’è un’ottima ragione per questo divieto.

[SIGLA di apertura]

La storia di HERT, perlomeno quella pubblica, inizia intorno alla metà degli anni Novanta del secolo scorso, ed è stata portata alla luce dal divulgatore scientifico Scott Manley in un video pubblicato recentemente su YouTube.

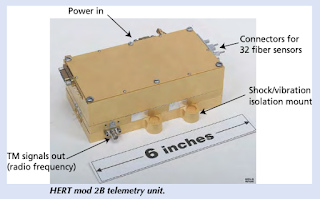

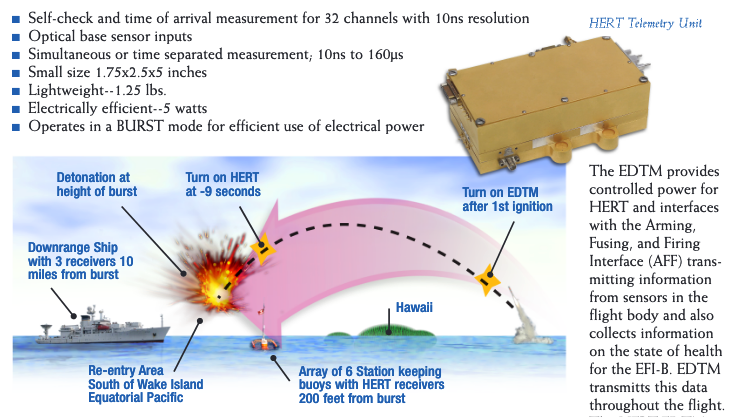

Si tratta di uno speciale computer per telemetria che aveva dei requisiti molto particolari: doveva trasmettere dati a circa 100 megabit al secondo (che negli anni Novanta erano una velocità notevolissima) ed era dotato di un processore FPGA o field-programmable gate array a 100 MHz. Questi FPGA, a differenza dei normali processori, sono riconfigurabili perché i loro circuiti non vengono fissati durante la fabbricazione e possono essere ridefiniti dal software che ci gira sopra, dando loro una flessibilità impareggiabile: un computer dotato di FPGA, in pratica, può modificare se stesso per adattarsi meglio al compito che deve svolgere. Oggi gli FPGA vanno molto di moda nel campo dell’intelligenza artificiale, ma ai tempi dell’esordio di HERT erano rari e nuovi: il primo FPGA commerciale era stato realizzato solo una decina d’anni prima, nel 1985.

Per contro, la memoria di HERT era davvero miserrima, persino per gli standard di allora: solo 1280 bit (sì, bit, non megabit o gigabit). Ma non era un problema, perché i dati che doveva raccogliere erano pochissimi e quello che contava era che quella poca memoria fosse incredibilmente veloce, perché doveva incamerare i dati di telemetria e passarli al trasmettitore radio che li inviava ai ricercatori del committente.

E il committente che aveva bisogno di questo strano computer era quasi altrettanto strano: era il Dipartimento per l’Energia degli Stati Uniti. Non è il tipo di ente che normalmente si associa all’informatica ad alte prestazioni, ma questo è un caso particolare, perché questo computer doveva attivarsi, raccogliere dati e trasmetterli nel giro di qualche milionesimo di secondo. Provate a pensare ai tempi di accensione del vostro computer o telefonino e immaginate, oltre trent’anni fa, un computer che era pronto all’uso nel giro di un milionesimo di secondo.

Probabilmente vi starete chiedendo il perché di tanta fretta di accendersi e partire. La spiegazione è nascosta nel significato della sigla HERT, che sta per High Explosive Radio Telemetry, ossia “telemetria via radio per alto esplosivo”. Questo piccolo computer dalle prestazioni pazzesche, infatti, doveva lavorare così in fretta perché doveva trasmettere tutti i dati raccolti prima che venisse distrutto intenzionalmente da un’esplosione. L’esplosione della bomba atomica all’interno della quale era installato.

----

Dietro l’etichetta apparentemente blanda del Dipartimento per l’Energia statunitense c’è in realtà la ricerca militare sulle armi nucleari, che ha ormai da alcuni decenni una sfida notevole da risolvere. Nel 1996 i test nucleari convenzionali, ossia quelli nei quali si fa esplodere una bomba, sono stati formalmente banditi da un trattato internazionale. Da ormai trent’anni, le grandi potenze nucleari firmatarie del trattato, ossia Stati Uniti, Russia, Cina, Francia e Regno Unito (cui si aggiungono molti altri paesi con arsenali nucleari relativamente minori), non effettuano più test pratici. E quindi questi paesi hanno un problema: come si fa a dimostrare che un’arma nucleare funziona davvero, se non la si può far esplodere?

[CLIP audio: il presidente USA dialoga con il presidente sovietico in “Il Dottor Stranamore” di Stanley Kubrick]

I test nucleari passati non sono sufficienti, perché le bombe invecchiano: contengono molti componenti e sostanze, come per esempio certi polimeri e gli esplosivi chimici che innescano la detonazione nucleare, che perdono le loro proprietà con il passare del tempo, e quindi bisogna fabbricarne periodicamente delle altre o sostituire questi componenti e materiali se si vuole mantenere quantitativamente stabile il proprio deterrente atomico. E bisogna fabbricarle o aggiornarle rispettando degli standard di precisione elevatissimi, altrimenti non funzioneranno.

In estrema sintesi, infatti, l’esplosione di una testata nucleare viene innescata usando degli esplosivi convenzionali, disposti in modo da produrre un’onda di pressione intorno al materiale radioattivo, comprimendolo immensamente in un tempo brevissimo. Se quest’onda non è uniforme, la reazione nucleare a catena non avviene correttamente e l’arma non funziona o funziona con potenza enormemente ridotta. Con le simulazioni al computer di oggi si può fare tanto, ma alla fine si tratta pur sempre di simulazioni, mentre per convincere i propri avversari potenziali che il proprio deterrente nucleare funziona davvero e non solo sulla carta, e che quindi non è il caso di attaccare, servono delle dimostrazioni pratiche.

È qui che entrava in gioco HERT: questo piccolo, velocissimo computer che pesava poco meno di 700 grammi veniva installato dentro una Flight Test Unit (FTU), una replica molto fedele di una bomba atomica ma priva di materiale nucleare e montata su un missile balistico lanciato verso un bersaglio fittizio, e i suoi sensori rilevavano in vari punti dell’ordigno la forma dell’onda di pressione che veniva prodotta dall’esplosivo convenzionale quando la bomba veniva fatta esplodere sul bersaglio. Nell’istante in cui iniziava l’esplosione, HERT doveva accendersi, raccogliere i dati che gli arrivavano da questi sensori, codificarli freneticamente e trasmetterli via radio. Doveva fare tutto questo entro non più di venti milionesimi di secondo, ossia nel tempo che ci metteva l’esplosione a raggiungerlo e distruggerlo. In pratica, la sua intera vita operativa durava cinquemila volte meno di un singolo battito di ciglia. Questa sì che è obsolescenza rapida.

Se i dati di questa telemetria confermavano che la forma dell’onda di pressione era regolare, dimostravano che la bomba funzionava e che quindi il deterrente nucleare era reale e credibile. Secondo la dottrina della distruzione reciproca garantita, questo deterrente scoraggiava i conflitti e quindi HERT, il computer meno durevole del mondo, a modo suo contribuiva alla pace.

---

Va detto che quello che si sa pubblicamente di HERT rappresenta lo stato dell’arte di tre decenni fa di una delle tante tecnologie informatiche estreme usate per la verifica delle armi nucleari, e non si sa quali dispositivi vengano usati oggi al suo posto, anche se i documenti governativi pubblici confermano che HERT, in una delle sue numerose versioni, è rimasto in uso almeno fino al 2007.

In compenso, si sa che il settore del controllo qualità delle testate nucleari, per così dire, utilizza anche oggi dei computer straordinariamente sofisticati, ma si tratta di dispositivi che durano decisamente più a lungo di HERT, anche perché hanno uno scopo molto differente: sono i supercalcolatori giganti che simulano con estrema finezza le reazioni di fusione nucleare, come Sierra e JADE, installati rispettivamente nel 2018 e nel 2016 presso la National Nuclear Security Administration in California e tuttora pienamente operativi, tanto che sono stati protagonisti poco citati dell’annuncio che ha fatto il giro del mondo, a dicembre 2022, di un importante passo avanti nella generazione di energia da fusione nucleare controllata.

Anche questi supercomputer, come il loro ben più effimero parente prossimo HERT, sono gestiti dal Dipartimento per l’Energia statunitense, e quel passo avanti è stato reso possibile dalle loro simulazioni digitali, che hanno definito i parametri dell’esperimento concreto che è stato al centro dell’annuncio. E benché i media si siano concentrati sugli aspetti energetici e le applicazioni commerciali della notizia, in realtà l’annuncio è stato di natura principalmente militare.

Riascoltando la conferenza stampa di presentazione si nota infatti che il fisico Marvin Adams che la conduce è vicedirettore per i programmi della Difesa degli Stati Uniti, e dice molto chiaramente (a 14:00) che il risultato annunciato ha sì delle implicazioni per l’energia pulita, ma soprattutto offre benefici diretti per la sicurezza nazionale, consentendo esperimenti che mantengono l’affidabilità e la credibilità del deterrente nucleare senza effettuare test esplosivi atomici. Esattamente come HERT, insomma.

Queste sono le sue parole [CLIP]:

“Fusion is an essential process in modern nuclear weapons, and fusion also has the potential for abundant clean energy. As you have heard, and you’ll hear more, the breakthrough at NIF does have ramifications for clean energy. More immediately, this achievement will advance our national security in at least three ways. First, it will lead to laboratory experiments that help NNSA defense programs continue to maintain confidence in our deterrent without nuclear explosive testing. Second, it underpins the credibility of our deterrent by demonstrating world-leading expertise in weapons-relevant technologies. That is, we know what we’re doing. Third, continuing to assure our allies that we know what we’re doing and continuing to avoid testing will advance our nonproliferation goals, also increasing our national security.”

----

Anche i supercomputer come JADE e Sierra, però, non durano a lungo: dopo qualche anno diventano obsoleti, superati da sistemi ancora più potenti. Ma se HERT è un caso estremo di vita breve di un dispositivo digitale, misurata in milionesimi di secondo, all’altro estremo c’è un computer decisamente longevo.

Secondo il Guinness dei Primati, il computer che è rimasto acceso e operativo più a lungo in tutta la storia della tecnologia digitale è in funzione ininterrottamente da 45 anni e 4 mesi: è entrato in attività il 20 agosto 1977 (il Dekatron britannico risale al 1951 ed è funzionante, ma non è rimasto continuamente attivo).

Anche questo computer ha a che fare con le radiazioni e con l’energia nucleare, ma stavolta le bombe non c’entrano: è infatti il CCS o Computer Command System, una coppia di computer interconnessi a bordo della sonda spaziale Voyager 2, lanciata appunto il 20 agosto del ’77. C’è anche un altro CCS ultralongevo: quello installato sulla sonda gemella Voyager 1, che nonostante la numerazione fu lanciata poco dopo la sorella Voyager 2, il 5 settembre 1977.

Questi Computer Command System sono alimentati ciascuno da un piccolo reattore nucleare che dovrebbe durare fino al 2030 circa e sopportano da 45 anni le radiazioni cosmiche dello spazio profondo; non contengono microprocessori ma soltanto componenti discreti e circuiti integrati, e hanno solo 70 kilobyte di memoria. Oggi i CCS si trovano a oltre venti miliardi di chilometri dalla Terra, ben oltre i pianeti del Sistema Solare, e sfrecciano a più di 15 chilometri al secondo nel gelo e nel buio, continuando a trasmettere diligentemente informazioni scientifiche da quasi mezzo secolo. Pensateci, la prossima volta che vi sentite in obbligo di cambiare telefonino perché vi sembra vecchio.

Fonti aggiuntive:

- Radio Frequency Overview of the High Explosive Radio Telemetry Project, Arizona.edu.

- System Integration and Advanced Telemetry, Osti.gov, pag. 44.

- High-Explosive Radio Telemetry, Lanl.gov.

- High Explosive Radio Telemetry System, Osti.gov.

-

Department of Energy - FY 2007 Congressional Budget Request, Volume

1, pag. 118-119.

- A History of LLNL Computers, LLNL.

- National Nuclear Security Administration.

- The One Thing Everyone’s Ignoring About the Fusion Energy Breakthrough, Daily Beast.

- Bridging Divider, Los Alamos National Laboratory.

- Nuclear-fusion lab achieves ‘ignition’: what does it mean?, Nature.

- National Ignition Facility achieves fusion ignition, LLNL.

- U.S. Officials Announce Major Nuclear Fusion Breakthrough Transcript, Rev.com.

- U.S. reaches a fusion power milestone. Will it be enough to save the planet?, NPR. Supercomputing’s Critical Role in the Fusion Ignition Breakthrough, HPCWire.com.

- Due Credit: Sierra, JADE and HPC’s Role in Livermore’s Fusion Ignition Breakthrough, InsideHPC.com.

-

FPGA vs. GPU vs. CPU – hardware options for AI applications, Avnet.com.