Un blog di Paolo Attivissimo, giornalista informatico e cacciatore di bufale

Informativa privacy e cookie: Questo blog include cookie di terze parti. Non miei (dettagli)

Prossimi eventi pubblici – Sostegno a questo blog – Sci-Fi Universe

Cerca nel blog

2019/04/05

Come ingannare l’Autopilot di Tesla e farlo andare contromano

Un gruppo di ricercatori del Keen Security Lab di Tencent ha dimostrato un metodo che consente di ingannare il sistema di guida Autopilot di Tesla e pone seri dubbi sull’affidabilità di tutti i sistemi di guida assistita di questo genere.

Premessa importante per chi non è pratico del settore: l’Autopilot di Tesla e tutti i sistemi analoghi attualmente installati su auto di varie marche sono dispositivi di guida assistita e non autonoma: sono ausilii al conducente, che però rimane sempre e comunque responsabile della conduzione del veicolo. Hanno delle limitazioni d’uso ben precise, spiegate dettagliatamente nei rispettivi manuali, che però molte persone decidono incoscientemente di ignorare.

Una di questa limitazioni è che il sistema di guida si aspetta che la strada non voglia ingannarlo intenzionalmente. Normalmente è così, ma i ricercatori hanno invece creato dei particolari adesivi che sono quasi invisibili ai conducenti ma vengono interpretati dal software di gestione del sistema di guida come se fossero delle linee continue che delimitano una corsia.

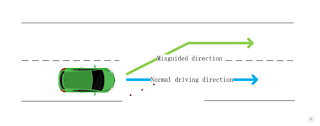

I ricercatori hanno piazzato tre di questi adesivi in diagonale sulla strada, orientandoli verso il centro della carreggiata, e l’Autopilot li ha interpretati come una deviazione della corsia, sterzando verso il centro della strada e invadendo la corsia opposta.

Questo è un difetto estremamente serio e difficile da correggere, anche perché si tratta di un sabotaggio intenzionale della segnaletica stradale. È l’equivalente informatico di qualcuno che altera i cartelli stradali o ridipinge le strisce di delimitazione di corsia per portarvi fuori strada o farvi andare contromano.

Tesla ha riconosciuto il problema e ha proposto l’unica difesa attualmente possibile, dicendo che lo scenario non è realistico “considerato che un conducente può facilmente scavalcare l’Autopilot in qualunque momento agendo sul volante o sui freni e deve sempre essere pronto a farlo”.

Il problema di questa giustificazione è che in realtà affidarsi all’Autopilot rischia di allungare i tempi di reazione in caso di problemi, come ho visto accadere di persona (come passeggero di varie Tesla): il conducente perde istanti preziosi per rendersi conto che il sistema di guida assistita sta sbagliando, gli concede il beneficio del dubbio e quindi può esitare prima di intervenire.

Per questo motivo si raccomanda di utilizzare questi sistemi esclusivamente in condizioni stradali ottimali (strisce ben visibili, strade senza curve improvvise) e di tenere sempre le mani sul volante (l’Autopilot, fra l’altro, suona l’allarme se si tolgono le mani per più di qualche secondo).

Gli esperti di Keen Security Lab dicono che la scelta di Tesla di usare solo sistemi di visione computerizzata per decidere che cosa costituisce una corsia “comporta rischi di sicurezza” e che “il riconoscimento della corsia di marcia in senso opposto è una delle funzioni necessarie per la guida autonoma su strade non chiuse”. Il semplice riconoscimento di due righe parallele per identificare una corsia, insomma, da solo non basta.

Maggiori dettagli su questi e altri risultati di questi esperti, insieme al loro rapporto tecnico, sono su Ars Technica.

Premessa importante per chi non è pratico del settore: l’Autopilot di Tesla e tutti i sistemi analoghi attualmente installati su auto di varie marche sono dispositivi di guida assistita e non autonoma: sono ausilii al conducente, che però rimane sempre e comunque responsabile della conduzione del veicolo. Hanno delle limitazioni d’uso ben precise, spiegate dettagliatamente nei rispettivi manuali, che però molte persone decidono incoscientemente di ignorare.

Una di questa limitazioni è che il sistema di guida si aspetta che la strada non voglia ingannarlo intenzionalmente. Normalmente è così, ma i ricercatori hanno invece creato dei particolari adesivi che sono quasi invisibili ai conducenti ma vengono interpretati dal software di gestione del sistema di guida come se fossero delle linee continue che delimitano una corsia.

I ricercatori hanno piazzato tre di questi adesivi in diagonale sulla strada, orientandoli verso il centro della carreggiata, e l’Autopilot li ha interpretati come una deviazione della corsia, sterzando verso il centro della strada e invadendo la corsia opposta.

Questo è un difetto estremamente serio e difficile da correggere, anche perché si tratta di un sabotaggio intenzionale della segnaletica stradale. È l’equivalente informatico di qualcuno che altera i cartelli stradali o ridipinge le strisce di delimitazione di corsia per portarvi fuori strada o farvi andare contromano.

Tesla ha riconosciuto il problema e ha proposto l’unica difesa attualmente possibile, dicendo che lo scenario non è realistico “considerato che un conducente può facilmente scavalcare l’Autopilot in qualunque momento agendo sul volante o sui freni e deve sempre essere pronto a farlo”.

Il problema di questa giustificazione è che in realtà affidarsi all’Autopilot rischia di allungare i tempi di reazione in caso di problemi, come ho visto accadere di persona (come passeggero di varie Tesla): il conducente perde istanti preziosi per rendersi conto che il sistema di guida assistita sta sbagliando, gli concede il beneficio del dubbio e quindi può esitare prima di intervenire.

Per questo motivo si raccomanda di utilizzare questi sistemi esclusivamente in condizioni stradali ottimali (strisce ben visibili, strade senza curve improvvise) e di tenere sempre le mani sul volante (l’Autopilot, fra l’altro, suona l’allarme se si tolgono le mani per più di qualche secondo).

Gli esperti di Keen Security Lab dicono che la scelta di Tesla di usare solo sistemi di visione computerizzata per decidere che cosa costituisce una corsia “comporta rischi di sicurezza” e che “il riconoscimento della corsia di marcia in senso opposto è una delle funzioni necessarie per la guida autonoma su strade non chiuse”. Il semplice riconoscimento di due righe parallele per identificare una corsia, insomma, da solo non basta.

Maggiori dettagli su questi e altri risultati di questi esperti, insieme al loro rapporto tecnico, sono su Ars Technica.

Iscriviti a:

Commenti sul post (Atom)

Nessun commento:

Posta un commento