È disponibile subito il podcast di oggi de Il Disinformatico della

Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate presso

www.rsi.ch/ildisinformatico

(link diretto) e qui sotto.

Le puntate del Disinformatico sono ascoltabili anche tramite

feed RSS,

iTunes,

Google Podcasts

e

Spotify.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

---

[CLIP: Mikko Hyppönen: “Fake text, fake speech, fake images, fake video,

and fake voices”]

Quando sono stati annunciati pubblicamente i primi software di intelligenza

artificiale capaci di generare immagini e testi, per molti imprenditori la

reazione istintiva è stata un entusiasmo sconfinato di fronte all’idea di

poter tagliare i costi di produzione dei contenuti mettendo al lavoro questi

nuovi servitori digitali al posto delle persone. Ma per molti altri, anche non

esperti di informatica, la reazione è stata ben diversa. Paura, pura e

semplice. Paura per il proprio posto di lavoro e paura per i possibili abusi,

facilmente prevedibili, di questa tecnologia.

Questa è la storia di come quella paura del possibile è oggi diventata reale,

raccontata attraverso tre casi recenti che sono un campanello d’allarme

urgente. Le temute truffe di identità basate sulle immagini sintetiche si sono

concretizzate e sono in corso; i siti di disinformazione generano fiumi di

falsità per incassare milioni; e le immagini di abusi su minori generate dal

software travolgono, per pura quantità, chi cerca di arginare questi orrori.

La politica nazionale e internazionale si china su queste questioni con i suoi

tempi inevitabilmente lunghi, ma nel frattempo i danni personali e sociali

sono già gravi e tangibili, ed è decisamente il momento di chiedersi se si

possa fare qualcosa di più di un coro tedioso di meritatissimi

“Ve l’avevamo detto”.

Benvenuti alla puntata del 30 giugno 2023 del Disinformatico, il

podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie

strane – e questa settimana inquietanti – dell’informatica. Io sono Paolo

Attivissimo.

[SIGLA di apertura]

Deepfake per furti ed estorsioni

Già nel 2017 gli utenti comuni si divertivano a usare app come

FaceApp per alterare il

proprio volto, e nel 2019 erano incantati dall’idea di inserirsi al posto agli

attori negli spezzoni di film celebri con app come

Zao, che davano risultati in pochi secondi, ma nel frattempo molti si ponevano

il problema dei possibili abusi di queste tecnologie nascenti di

deepfake basate sull’intelligenza artificiale, soprattutto in termini

di privacy e di sorveglianza di massa.

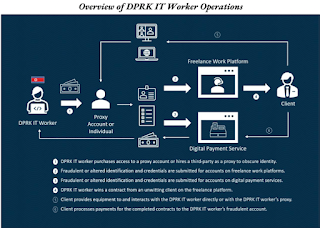

Il crimine informatico organizzato, invece, stava aspettando il passo

successivo: i deepfake in tempo reale, che oggi sono facilmente

disponibili su un normale personal computer dotato di una scheda grafica di

buona potenza. Già da alcuni anni è possibile alterare

istantaneamente la propria voce in modo da imitare quella di qualunque

altra persona di cui si abbia un breve campione. E questa produzione in tempo

reale cambia tutto, perché rende possibile truffe atroci alle quali siamo

impreparati.

Immaginate di ricevere una telefonata nella quale vostro figlio, o il vostro

partner, vi dice con tono disperato che è coinvolto in un incidente stradale

ed è in arresto, e poi passa la linea a un agente di polizia che spiega che è

possibile pagare una cauzione e fornisce le istruzioni per farlo. Questa è la

tecnica usata per esempio da un ventitreenne, Charles Gillen, in Canada, che

nel giro di soli tre giorni, all’inizio di quest’anno, è riuscito a farsi

consegnare

l’equivalente di circa 135.000 franchi svizzeri o euro da otto vittime prima

di essere

arrestato

insieme a un complice. Tutte le vittime hanno detto di aver riconosciuto

chiaramente la voce del proprio familiare al telefono.

La prima frode di questo genere, però, risale al

2019, quando un dirigente di un’azienda britannica nel settore energetico fu

ingannato

da un deepfake della voce del proprio direttore, di cui riconobbe anche

il lieve accento tedesco, ed eseguì il suo ordine di trasferire immediatamente

220.000 euro sul conto di un asserito fornitore, dal quale poi i soldi presero

il volo.

Questa tecnica richiede tre ingredienti: un campione della voce della persona

da imitare, facilmente estraibile da qualunque video o messaggio vocale

postato su Internet; il software di intelligenza artificiale o

machine learning per alterare la propria voce in tempo reale,

altrettanto facile da procurare; e delle informazioni personali dettagliate e

attendibili sulla persona che si vuole simulare.

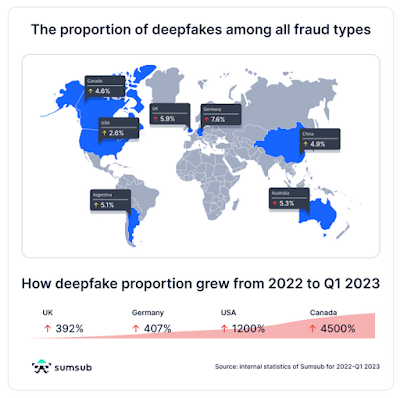

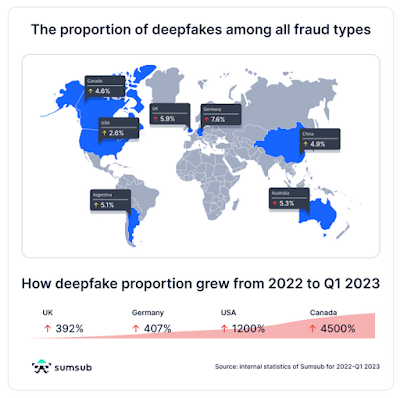

Il 2023 sembra essere l’anno di svolta per queste frodi: secondo

Sumsub, società specializzata nel settore della verifica di identità online, il

numero dei deepfake

rivelati nel primo trimestre di quest’anno ha superato del 10% quello di

tutto il 2022. E gli esperti

sospettano

che furti massicci di dati personali attendibili, come quello messo a segno

dal gruppo criminale informatico russofono Cl0p, descritto nella

puntata precedente del Disinformatico, servano per alimentare proprio questo tipo di falsificazione dell’identità

[visto che stranamente Cl0p non ha inviato richieste di riscatto alle

aziende di cui ha saccheggiato gli archivi].

Questa situazione mette in crisi qualunque banca o pubblica amministrazione

che si appoggi all’identificazione via Internet per gestire i conti o le

posizioni degli utenti: oggi va molto di moda permettere alle persone di

aprire e gestire un conto corrente o interrogare un servizio sanitario tramite

telefonino, usando un video in tempo reale per verificare l’identità invece di

presentarsi a uno sportello, perché questo riduce i costi per l’azienda ed è

più comodo per l’utente.

Ma di fronte ai deepfake video in tempo reale questo risparmio e questa

comodità vanno rimessi seriamente in discussione, e per difendersi da truffe

come queste dobbiamo tutti imparare a non fidarci dei nostri sensi e dei

nostri istinti se c’è di mezzo un dispositivo elettronico, e a chiedere

conferme di altro genere, come per esempio una parola chiave concordata o una

risposta a una domanda su qualcosa che nessun altro può sapere.

[Un’altra

possibilità

è chiedere alla persona in video di mettersi di profilo: questo spesso fa

impazzire i software di deepfake in tempo reale, che difficilmente vengono

addestrati per questa posizione del viso]

Fiumi di fake news generate dall’IA per fare soldi

Stanno diventando sempre più numerosi i siti Internet che pubblicano enormi

quantità di notizie false generate automaticamente tramite l’intelligenza

artificiale, e ben 141 marche molto conosciute stanno finanziando questi siti

senza rendersene conto. Lo

segnala

Newsguard, un sito di valutazione

dell’affidabilità delle fonti di notizie gestito da giornalisti che offre

anche un’estensione per browser che avvisa l’utente quando visita un sito che

pubblica regolarmente notizie false.

Soltanto nel mese di maggio 2023, gli analisti di NewsGuard hanno più che

quadruplicato il numero di siti di fake news segnalati dal loro

software, da 49 a 217, e ne hanno aggiunti altri

sessanta

a giugno. Sono insomma quasi trecento i siti di questo genere catalogati, che

pubblicano fino a 1200 pseudoarticoli al giorno ciascuno e coprono almeno 13

lingue, dall'arabo al ceco all’italiano al thailandese. Per fare un paragone,

un giornale medio pubblica circa 150 notizie al giorno.

È un vero e proprio fiume in piena di fake news, reso possibile da

strumenti automatici di generazione di testi come ChatGPT, e confezionato in

siti che hanno una veste grafica e un nome apparentemente generici e

rispettabili. Un fiume che era perfettamente prevedibile non appena sono nati

i generatori di testi.

Ma l’intelligenza artificiale non è l’unica tecnologia che permette

l’esistenza di questi enormi avvelenatori dell’informazione: c’è di mezzo

anche il cosiddetto programmatic advertising. Questi siti ingannevoli

esistono allo scopo di fare soldi, non di disinformare in senso stretto, e

fanno soldi grazie al fatto che i grandi servizi di pubblicità online, come

per esempio Google e Meta, usano un complesso meccanismo automatico di

piazzamento delle pubblicità nei vari siti, basato sulla profilazione degli

interessi degli utenti: il programmatic advertising, appunto.

Il risultato di questo meccanismo è che gli inserzionisti spesso non hanno

idea di dove venga pubblicata la loro pubblicità, e siccome i servizi

pubblicitari pagano i siti che ospitano le loro inserzioni, alcuni

imprenditori senza scrupoli creano siti pieni di notizie-fuffa per incassare

soldi dalle pubblicità. Più pagine di notizie si pubblicano, più spazi

pubblicitari ci sono, e quindi a loro conviene trovare il modo di generare il

maggior numero possibile di pagine. E quel modo è, appunto, l’intelligenza

artificiale.

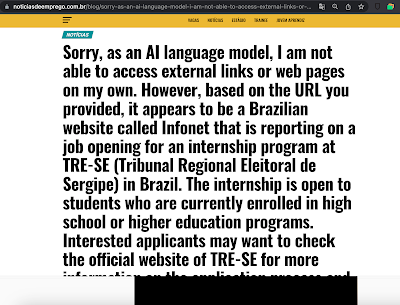

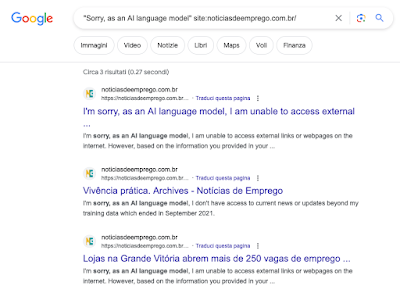

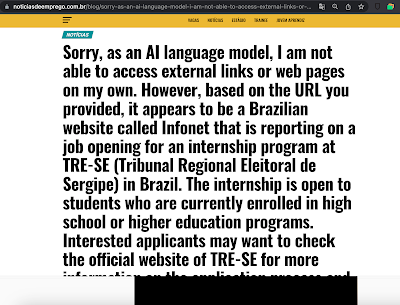

Il risultato a volte è quasi comico, come nel caso di un sito di pseudonotizie

brasiliano, Noticias de Emprego (noticiasdeemprego.com.br), nel

quale un “articolo” inizia addirittura con le parole

“Mi scuso, ma come modello linguistico di intelligenza artificiale non sono

in grado di accedere a collegamenti esterni o pagine Web su Internet”.

È un indicatore decisamente sfacciato e facilmente riconoscibile di contenuti

generati dall’intelligenza artificiale senza la benché minima supervisione

umana, eppure i grandi servizi pubblicitari online non sembrano fare granché

per evitare di foraggiarli con i soldi delle grandi marche: banche, agenzie di

autoloneggio, compagnie aeree, catene di grandi magazzini e altro ancora.

Eppure le regole pubblicitarie di Google dicono molto chiaramente che non

vengono accettati siti che includono contenuti generati automaticamente di

tipo spam. Nonostante questo, Newsguard nota che oltre il 90% delle pubblicità

che ha identificato su questi siti di pseudoinformazione è stato fornito da

Google.

Possiamo difenderci da questi siti ingannevoli e ostacolare i loro guadagni

installando nei nostri computer e telefonini dei filtri che blocchino le

pubblicità, i cosiddetti adblocker, che sono gratuiti, e strumenti che

segnalino i siti di questo genere, come appunto

quello proposto da Newsguard, che però costa 5 euro al mese.

Ovviamente il problema sarebbe risolvibile a monte vietando del tutto il

tracciamento pubblicitario e l’inserimento automatico delle pubblicità nei

siti, ma i legislatori sembrano molto riluttanti ad agire in questo senso,

mentre Google pare così preso dal vendere spazi pubblicitari da non

controllare dove siano quegli spazi. E così, in nome dei soldi, Internet si

riempie di siti spazzatura che tocca a noi scansare e ripulire a spese nostre.

Fonte aggiuntiva:

Gizmodo.

Immagini di abusi su minori generati dall’IA

Il terzo disastro perfettamente prevedibile di questa rassegna è anche il più

infame. La BBC ha pubblicato un’indagine

che ha documentato l’uso di software di intelligenza artificiale per generare

immagini sintetiche di abusi sessuali su minori [CSAM, dalle iniziali di Child Sexual Abuse Material] e venderle tramite

abbonamenti a comuni servizi di condivisione di contenuti a pagamento come

Patreon, che sono inconsapevoli di essere coinvolti.

Il software di intelligenza artificiale usato, secondo la BBC, è Stable

Diffusion, la cui versione normale ha delle salvaguardie che impediscono di

produrre questo tipo di immagine. Ma queste salvaguardie sono facilmente

rimovibili da chi installa questo software sul proprio computer, e a quel

punto è sufficiente dare una descrizione testuale del contenuto che si

desidera e il software, impassibile, lo genererà.

La quantità di materiale di questo genere prodotto in questo modo è enorme:

ciascun offerente propone in media almeno mille nuove immagini al mese. E

anche se c’è chi si giustifica dicendo che nessun bambino reale viene abusato

perché le immagini sono appunto sintetiche, le autorità e gli esperti notano

che queste immagini sintetiche vengono generate partendo da un repertorio di

immagini reali e che gli stessi siti che offrono le pseudofoto propongono

spesso anche immagini di abusi effettivi. In ogni caso, la detenzione di

immagini di questo genere, reali o generate, è reato in quasi tutti i paesi

del mondo.

Verrebbe da pensare che materiale atroce di questo genere sia relegato nei

bassifondi di Internet, magari nel tanto mitizzato dark web, ma molto

più banalmente si trova spesso su normali siti web. Secondo la BBC, infatti,

in Giappone la condivisione di disegni sessualizzati di bambini non è reato, e

quindi molti offerenti di queste immagini le pubblicano apertamente, usando

hashtag identificativi appositi. Uno di questi siti residenti in

Giappone, Pixiv, ha dichiarato che dal 31 maggio scorso ha bandito

“tutte le rappresentazioni fotorealistiche di contenuti sessuali che

coinvolgono minori”. Noterete che Pixiv parla solo di immagini fotorealistiche. E viene

da chiedersi come mai questo divieto sia entrato in vigore solo ora.

Uno dei problemi più grandi di questa montagna di immagini di abusi è che

rende sempre meno efficaci gli strumenti adottati dalle forze di polizia e dai

social network per tracciare e bloccare questo materiale. Quando le autorità

trovano un’immagine o un video di questo genere, ne producono una sorta di

impronta digitale matematica, un hash, che non contiene l’immagine e

non permette di ricostruirla ma consente di identificarla automaticamente. Gli

elenchi di questi hash possono essere condivisi senza problemi e

inclusi nei filtri automatici delle applicazioni, dei siti di condivisione e

dei social network. Ma se i software di intelligenza artificiale consentono di

generare innumerevoli immagini sempre differenti, questo sistema collassa

rapidamente.

L’unica difesa possibile, oltre all’informazione, all’educazione, a una

discussione schietta della questione e al lavoro incessante delle autorità,

che hanno riscosso successi importanti

anche recentemente in Svizzera, è segnalare queste immagini ai facilitatori dei servizi di pagamento, che

bloccheranno gli account e i soldi che contengono. Ma è un lavoro

delicatissimo, nel quale la prima regola è mai mandare copie di queste

immagini a nessuno, neppure alle autorità stesse, perché si diventerebbe

detentori e condivisori di questo materiale. Si deve mandare sempre e solo il

link che porta al contenuto e non conservare copie o screenshot di quel

contenuto. Lo sa bene, paradossalmente, proprio la BBC, quella che ha svolto

quest’indagine delicatissima: nel 2017 segnalò che Facebook stava ospitando

immagini di abusi su minori e fece l’errore di inviare degli screenshot di

queste immagini a Facebook invece di mandare i link come richiesto. Per tutta

risposta, Facebook fu costretta a

denunciare

alla polizia i giornalisti dell’emittente britannica.

In casi come questi, è meglio stare alla larga ed evitare ogni tentazione, per

quanto umanamente comprensibile, di vigilantismo.

Fonte aggiuntiva:

Ars Technica.

Intanto, è ormai chiaro che il vaso di Pandora dell’intelligenza artificiale è

stato aperto, nonostante tutte le ammonizioni, non lo si può più chiudere e ci

tocca conviverci. Non resta che sperare che da questo vaso escano anche tante

applicazioni positive. Ma questa è un’altra storia, da raccontare in un’altra

puntata.

Chiusura

Anche questa puntata del Disinformatico è infatti giunta al termine:

grazie di averla seguita. Questo podcast è una produzione della RSI

Radiotelevisione svizzera. Le nuove puntate del Disinformatico vengono messe online ogni venerdì mattina presso

www.rsi.ch/ildisinformatico e su tutte le principali piattaforme

podcast. I link e le fonti di riferimento che ho citato in questa puntata e

nelle precedenti sono disponibili presso Disinformatico.info. Per

segnalazioni, commenti o correzioni, scrivetemi una mail all’indirizzo

paolo.attivissimo@rsi.ch. A presto.