Sta circolando la notizia che dei ricercatori della Georgetown University e della University of California hanno dimostrato di poter eseguire comandi a distanza sugli smartphone Android e iOS ricorrendo a istruzioni vocali fortemente distorte, diffuse da un altoparlante. Il video è notevole, anche perché i comandi sono incomprensibili all’orecchio umano (perlomeno al mio) ma vengono capiti egregiamente dal telefonino, e hanno una sonorità inquietante.

Il risultato, nel video, è che un comando vocale riesce a far visitare un sito (che potrebbe essere un sito ostile o imbarazzante) e addirittura riesce a mettere il telefonino in modalità aereo: in pratica lo spegne a distanza, rendendo irreperibile il suo proprietario.

Ma la realtà dei fatti non è così semplice ed elegante come mostrato nel video, perlomeno secondo le mie prove. Infatti non sono riuscito a replicare gli effetti descritti facendo ascoltare il video all mio Nexus 5X, sul quale ho Android 6.0.1, che ho impostato andando in Impostazioni - Lingua e immissione - Lingua - English (US) e poi attivando OK Google (Settings - Language and input - Google Voice Typing - "Ok Google" detection - Always on), probabilmente perché questa versione di Android confronta l’audio con i campioni della mia voce che mi ha chiesto e accetta solo la mia voce o una voce molto simile.

L’articolo scientifico originale cita la versione 4.4.2 di Android (oltre alla versione 9.1 di iOS), per cui ho riesumato un vecchio Switel con Android 4.4.2 e l’ho configurato come sopra. Stavolta Google non mi ha chiesto campioni della mia voce e il riconoscimento dei comandi distorti è andato un pochino meglio: il comando “Ok Google” è stato riconosciuto, ma soltanto quando ho riprodotto l’audio mettendo l’altoparlante a ridosso del microfono dello smartphone.

Morale della storia: la dimostrazione dei ricercatori è concettualmente intrigante, perché mostra una vulnerabilità che molti non immaginano, ma in termini realistici le possibilità di eseguire un attacco in questo modo sono piuttosto modeste: serve un Android vecchio, sul quale sia attiva l’opzione OK Google e sia anche stata scelta la lingua corrispondente a quella delle registrazioni audio usate per l’attacco. Inoltre le condizioni audio necessarie sono particolarmente delicate.

In realtà se avete un Android vulnerabile a questo attacco dovreste preoccuparvi del fatto che state usando una versione di Android troppo antica, che vi espone a ben altri attacchi più semplici e probabili. Ma questa è un’altra storia.

Un blog di Paolo Attivissimo, giornalista informatico e cacciatore di bufale

Informativa privacy e cookie: Questo blog include cookie di terze parti. Non miei (dettagli)

Prossimi eventi pubblici – Sostegno a questo blog – Sci-Fi Universe

Cerca nel blog

2016/07/07

Incidente Tesla: il nome Autopilot è ingannevole? Due parole con Elon Musk

Questo articolo vi arriva gratuitamente e senza pubblicità grazie alle donazioni dei lettori. Se vi piace, potete incoraggiarmi a scrivere ancora (anche con un microabbonamento). Ultimo aggiornamento: 2016/07/10 10:00.

Ieri (6 luglio) Tesla Motors ha pubblicato una risposta tecnica a un articolo di Fortune che la accusa di aver proceduto all’offerta pubblica di oltre due miliardi di dollari di azioni senza aver informato il pubblico dell’incidente automobilistico avvenuto in Florida nel quale è stata coinvolta una Tesla Model S che procedeva con il sistema di guida assistita inserito. Secondo Fortune questo incidente andava comunicato al pubblico prima dell’offerta di azioni perché rivela un difetto importante nel sistema di guida assistita (che Tesla Motors chiama Pilota automatico o Autopilot e ha introdotto a ottobre 2015) che avrà effetto sul valore delle azioni dell’azienda.

Tesla Motors ha risposto dicendo che l’incidente è stato causato innanzi tutto dal fatto che un TIR ha tagliato la strada al conducente dell’auto e che non ci sono indicazioni che l’Autopilot non abbia funzionato “come progettato e descritto agli utenti: specificamente, come sistema di ausilio alla guida che mantiene la posizione del veicolo in corsia e adatta la velocità del veicolo al traffico circostante”. In originale:

Elon Musk ha risposto via Twitter con toni decisamente aggressivi, rimproverando Alan Murray, il giornalista di Fortune, di aver scritto un “articolo di fandonie” che ha “aumentato i vostri ricavi pubblicitari – perché non scrivete articoli sul milione e passa di morti/anno causati dalle altre case automobilistiche?”

Ne è nata una discussione, alla quale mi sono aggiunto anch’io notando che il fatto di chiamare Autopilot un sistema di guida assistita crea, a mio parere, delle attese irrealistiche nell’opinione pubblica. Le altre case automobilistiche che offrono sistemi di guida assistita non usano nomi così accattivanti come Pilota automatico.

Nell’utente medio, quello che non approfondisce i dettagli tecnici ma semplicemente compra l’auto come compra una lavatrice (mi ci metto anch’io), e nell’opinione pubblica (per gran parte della quale la Tesla è solo “quell’auto elettrica carissima che va da sola”), il termine Autopilot evoca secondo me eccessivamente l’idea di una guida autonoma, durante la quale il conducente può fare altro. Mi chiedo, e ho chiesto ai partecipanti alla discussione, se questo nome abbia creato una falsa impressione d’infallibilità e di potenza prestazionale dell’Autopilot che ha indotto molti a sopravvalutarne le reali capacità.

Il risultato di questa sopravvalutazione è il numero esagerato di video popolarissimi nei quali gli utenti Tesla dimostrano che l’auto tiene la strada da sola mentre il guidatore chiude o si copre gli occhi o legge il giornale: cose proibitissime dal manuale dell’auto e dal materiale informativo di Tesla Motors. Persino la moglie di Elon Musk è stata colta a fare cose di questo genere. Il risultato è, forse, un morto in Florida, accompagnato da un’enorme reazione mediatica a questo incidente, primo nel suo genere. L’intervista della ABC ai testimoni dell’incidente raccoglie la loro paura per un’auto che ha – dicono – proseguito la propria corsa autonomamente dopo la collisione (non è andata così, ma la loro impressione è stata quella). C’è addirittura chi, come Vanity Fair, dice che il nome Autopilot andrebbe cambiato in favore di qualcosa che “faccia meno paura”.

Tesla Motors sottolinea a ogni occasione che l’Autopilot è un sistema di guida assistita nel quale il conducente è comunque responsabile e durante il cui uso è necessaria la massima vigilanza. Ma di fatto l’incidente mortale in Florida è accaduto prima di tutto perché un TIR ha tagliato la strada a una Tesla (prima causa fondamentale, che non va dimenticata) e secondariamente perché il conducente non ha nemmeno tentato la frenata o la sterzata, come se non avesse visto avvicinarsi e poi mettersi di traverso davanti a sé un ostacolo enorme. Perché non l’ha visto? Era distratto perché si fidava troppo di un sistema che Tesla Motors propone come guida assistita ma chiama in modo ingannevole Pilota automatico?

Questa è una foto, tratta da Google Street View, del luogo dell’incidente, presa dal punto di vista del conducente della Tesla. Il TIR proveniva dalla carreggiata a sinistra e ha attraversato l’incrocio a raso. Era pomeriggio, in ottime condizioni di visibilità.

Come ha fatto il guidatore della Tesla, il quarantenne Joshua Brown, a non vedere l’autoarticolato che svoltava, si inseriva nell’incrocio e gli si presentava davanti? Come ha fatto a non accorgersene al punto di non toccare nemmeno il pedale del freno o tentare di schivarlo? Forse ci sono dettagli che ancora non sono stati resi noti e che cambiano tutto, ma quello che si sa fin qui sembra suggerire che il conducente non fosse affatto attento e vigile come invece Tesla ribadisce che dev’essere chi guida con l’Autopilot. L’analisi pubblicata da The Drive indica che se Brown fosse stato attento, anche procedendo alla velocità più alta stimata dai testimoni, avrebbe avuto tempo almeno di toccare il pedale del freno.

Cosa non meno importante: in queste condizioni, come mai l’Autopilot non è intervenuto nemmeno per tentare una frenata disperata? Come mai i sensori (telecamera e radar) non hanno visto un autoarticolato che si metteva di traverso? Formalmente questo fatto non è un difetto dell’Autopilot, perché l’Autopilot non è progettato per riconoscere veicoli messi di traverso. Anzi, dice Musk, il suo radar è progettato per ignorare grandi superfici messe di traverso sopra la carreggiata: vale a dire, i cartelli stradali sospesi, ma a quanto pare anche le fiancate di TIR il cui rimorchio non ha barriere laterali sotto il pianale.

Quanti proprietari di Tesla sono al corrente di questa particolarissima limitazione e sanno che la loro auto ipersofisticata è in realtà cieca agli ostacoli proprio all’altezza dell’abitacolo?

Come giornalista informatico, lavorando alla radio, avendo un blog e un profilo Twitter abbastanza seguiti e facendo parecchi incontri pubblici, mi capita spesso di sentire le opinioni di tante persone sugli oggetti tecnologici, comprese le auto “intelligenti”. E vedo regolarmente che è diffusissima l’idea che le Tesla, in particolare, siano automobili autonome, nelle quali ti siedi al volante ma fanno tutto loro. C’è una visione magica della tecnologia Tesla che ricorda molto quella dei prodotti Apple dell’era di Steve Jobs.

A un certo punto della discussione è intervenuto Elon Musk (o chi gestisce per lui il suo account Twitter), giustificando il nome Autopilot con un paragone con il pilota automatico aeronautico:

Io e altri abbiamo fatto notare, insomma, che un pilota d’aereo riceve un addestramento di gran lunga superiore a quello di un automobilista e che specialmente per i sistemi di guida assistita l’addestramento dato al conducente si limita quasi sempre a una spiegazione presso il concessionario, al momento del ritiro dell’auto, e a un invito a leggersi il manuale. Un pilota di linea guida per lavoro, ed è pagato per concentrarsi sul pilotaggio: un automobilista no.

Ci sono inoltre delle differenze enormi fra un pilota automatico moderno (quello di un aereo di linea, per esempio) e l’Autopilot di Tesla.

– Un pilota automatico d’aereo ha un sistema anticollisione automatico che negozia con l'altro veicolo la traiettoria per evitare collisioni (TCAS). L’Autopilot no.

– Un pilota automatico d’aereo è in grado di gestire la rotta per raggiungere la destinazione indicata dal pilota: l’Autopilot non segue la strada indicata dal navigatore, ma semplicemente segue le strisce della corsia della strada sulla quale si trova.

– In cielo non ci sono semafori e la Tesla non riconosce i semafori. Se è in Autopilot, attraverserà un incrocio col rosso.

– Un pilota automatico d'aereo non è cieco a qualunque oggetto si trovi davanti e sopra, ad altezza d'abitacolo.

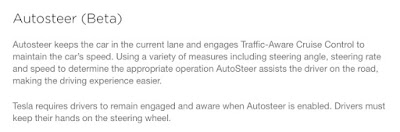

– A un pilota di aereo di linea non si chiede di accettare come “pilota automatico” un software che è ancora sperimentale.*

*Elon Musk, a ottobre 2015, ha presentato l’Autopilot di Tesla Motors dicendo chiaramente “We still think of it as a public beta, so we want people to be quite careful” e ;ancora oggi l’Autopilot è definito dal costruttore almeno in parte come “software beta”. Inoltre al conducente che sceglie di installarlo viene chiesto di accettare una clausola apposita di responsabilità limitata.

Il paragone aeronautico non regge, insomma. Forse dovremmo usare, per il sistema di guida della Tesla, un nome meno ambiguo, come Driver Assistant, Pilot Assistant, Sidekick o qualcos’altro che chiarisca inequivocabilmente il ruolo di supporto al guidatore e non di suo sostituto (fra l’altro, il manuale dell’Autopilot versione 7.1 parla di “Driver Assistance hardware”).

Certo, ci saranno sempre gli stupidi e gli incoscienti che ignoreranno gli avvisi e i nomi, non importa quanto siano chiari (come succede per le cinture di sicurezza, per esempio): ma se un nome meno ingannevole e una campagna promozionale meno sensazionale possono salvare delle vite, secondo me vale la pena di adottarli. Spero che Elon Musk aggiorni il software e i sensori in modo da rendere più difficili comportamenti pericolosi che abusano dell’Autopilot: per esempio con una telecamerina che riconosca i contorni del volto del conducente e si accorga se sta guardando in avanti o no.

Adoro le auto elettriche e le auto autonome/assistite e in particolare le Tesla, tanto da averne ordinata una (la Model 3): inquinano meno e promettono di ridurre gli incidenti e il tempo perso nella guida. Mi dispiacerebbe molto se un nome ingannevole come Autopilot causasse una reazione ostile alle auto di questo tipo, alimentata dall’ignoranza, dal pregiudizio e dalla disattenzione. Presentare questa tecnologia come se fosse matura, quando in realtà non lo è, è pericoloso, perché spinge a una guida eccessivamente fiduciosa e disattenta. Ed è pericoloso in generale per il futuro, soprattutto adesso che si sta discutendo, negli Stati Uniti, la normativa federale sulle auto autonome.

Siamo a una svolta decisiva in un campo tecnologico che ha un potere enorme di trasformare la nostra società: vediamo di affrontarla con prudenza e con informazioni corrette.

Ieri (6 luglio) Tesla Motors ha pubblicato una risposta tecnica a un articolo di Fortune che la accusa di aver proceduto all’offerta pubblica di oltre due miliardi di dollari di azioni senza aver informato il pubblico dell’incidente automobilistico avvenuto in Florida nel quale è stata coinvolta una Tesla Model S che procedeva con il sistema di guida assistita inserito. Secondo Fortune questo incidente andava comunicato al pubblico prima dell’offerta di azioni perché rivela un difetto importante nel sistema di guida assistita (che Tesla Motors chiama Pilota automatico o Autopilot e ha introdotto a ottobre 2015) che avrà effetto sul valore delle azioni dell’azienda.

Tesla Motors ha risposto dicendo che l’incidente è stato causato innanzi tutto dal fatto che un TIR ha tagliato la strada al conducente dell’auto e che non ci sono indicazioni che l’Autopilot non abbia funzionato “come progettato e descritto agli utenti: specificamente, come sistema di ausilio alla guida che mantiene la posizione del veicolo in corsia e adatta la velocità del veicolo al traffico circostante”. In originale:

To be clear, this accident was the result of a semi-tractor trailer crossing both lanes of a divided highway in front of an oncoming car. Whether driven under manual or assisted mode, this presented a challenging and unexpected emergency braking scenario for the driver to respond to. In the moments leading up to the collision, there is no evidence to suggest that Autopilot was not operating as designed and as described to users: specifically, as a driver assistance system that maintains a vehicle's position in lane and adjusts the vehicle's speed to match surrounding traffic.

Elon Musk ha risposto via Twitter con toni decisamente aggressivi, rimproverando Alan Murray, il giornalista di Fortune, di aver scritto un “articolo di fandonie” che ha “aumentato i vostri ricavi pubblicitari – perché non scrivete articoli sul milione e passa di morti/anno causati dalle altre case automobilistiche?”

@alansmurray Yes, it was material to you -- BS article increased your advertising revenue. Just wasn't material to TSLA, as shown by market.— Elon Musk (@elonmusk) 5 luglio 2016

@alansmurray If you care about auto deaths as material to stock prices, why no articles about 1M+/year deaths from other auto companies?— Elon Musk (@elonmusk) 5 luglio 2016

Nell’utente medio, quello che non approfondisce i dettagli tecnici ma semplicemente compra l’auto come compra una lavatrice (mi ci metto anch’io), e nell’opinione pubblica (per gran parte della quale la Tesla è solo “quell’auto elettrica carissima che va da sola”), il termine Autopilot evoca secondo me eccessivamente l’idea di una guida autonoma, durante la quale il conducente può fare altro. Mi chiedo, e ho chiesto ai partecipanti alla discussione, se questo nome abbia creato una falsa impressione d’infallibilità e di potenza prestazionale dell’Autopilot che ha indotto molti a sopravvalutarne le reali capacità.

Il risultato di questa sopravvalutazione è il numero esagerato di video popolarissimi nei quali gli utenti Tesla dimostrano che l’auto tiene la strada da sola mentre il guidatore chiude o si copre gli occhi o legge il giornale: cose proibitissime dal manuale dell’auto e dal materiale informativo di Tesla Motors. Persino la moglie di Elon Musk è stata colta a fare cose di questo genere. Il risultato è, forse, un morto in Florida, accompagnato da un’enorme reazione mediatica a questo incidente, primo nel suo genere. L’intervista della ABC ai testimoni dell’incidente raccoglie la loro paura per un’auto che ha – dicono – proseguito la propria corsa autonomamente dopo la collisione (non è andata così, ma la loro impressione è stata quella). C’è addirittura chi, come Vanity Fair, dice che il nome Autopilot andrebbe cambiato in favore di qualcosa che “faccia meno paura”.

Tesla Motors sottolinea a ogni occasione che l’Autopilot è un sistema di guida assistita nel quale il conducente è comunque responsabile e durante il cui uso è necessaria la massima vigilanza. Ma di fatto l’incidente mortale in Florida è accaduto prima di tutto perché un TIR ha tagliato la strada a una Tesla (prima causa fondamentale, che non va dimenticata) e secondariamente perché il conducente non ha nemmeno tentato la frenata o la sterzata, come se non avesse visto avvicinarsi e poi mettersi di traverso davanti a sé un ostacolo enorme. Perché non l’ha visto? Era distratto perché si fidava troppo di un sistema che Tesla Motors propone come guida assistita ma chiama in modo ingannevole Pilota automatico?

Questa è una foto, tratta da Google Street View, del luogo dell’incidente, presa dal punto di vista del conducente della Tesla. Il TIR proveniva dalla carreggiata a sinistra e ha attraversato l’incrocio a raso. Era pomeriggio, in ottime condizioni di visibilità.

Come ha fatto il guidatore della Tesla, il quarantenne Joshua Brown, a non vedere l’autoarticolato che svoltava, si inseriva nell’incrocio e gli si presentava davanti? Come ha fatto a non accorgersene al punto di non toccare nemmeno il pedale del freno o tentare di schivarlo? Forse ci sono dettagli che ancora non sono stati resi noti e che cambiano tutto, ma quello che si sa fin qui sembra suggerire che il conducente non fosse affatto attento e vigile come invece Tesla ribadisce che dev’essere chi guida con l’Autopilot. L’analisi pubblicata da The Drive indica che se Brown fosse stato attento, anche procedendo alla velocità più alta stimata dai testimoni, avrebbe avuto tempo almeno di toccare il pedale del freno.

Cosa non meno importante: in queste condizioni, come mai l’Autopilot non è intervenuto nemmeno per tentare una frenata disperata? Come mai i sensori (telecamera e radar) non hanno visto un autoarticolato che si metteva di traverso? Formalmente questo fatto non è un difetto dell’Autopilot, perché l’Autopilot non è progettato per riconoscere veicoli messi di traverso. Anzi, dice Musk, il suo radar è progettato per ignorare grandi superfici messe di traverso sopra la carreggiata: vale a dire, i cartelli stradali sospesi, ma a quanto pare anche le fiancate di TIR il cui rimorchio non ha barriere laterali sotto il pianale.

@artem_zin @theaweary Radar tunes out what looks like an overhead road sign to avoid false braking events— Elon Musk (@elonmusk) 30 giugno 2016

Come giornalista informatico, lavorando alla radio, avendo un blog e un profilo Twitter abbastanza seguiti e facendo parecchi incontri pubblici, mi capita spesso di sentire le opinioni di tante persone sugli oggetti tecnologici, comprese le auto “intelligenti”. E vedo regolarmente che è diffusissima l’idea che le Tesla, in particolare, siano automobili autonome, nelle quali ti siedi al volante ma fanno tutto loro. C’è una visione magica della tecnologia Tesla che ricorda molto quella dei prodotti Apple dell’era di Steve Jobs.

A un certo punto della discussione è intervenuto Elon Musk (o chi gestisce per lui il suo account Twitter), giustificando il nome Autopilot con un paragone con il pilota automatico aeronautico:

@disinformatico @Eddy_Jahn In other words, the intended implication is that a driver must remain alert, just as a pilot must remain alert.— Elon Musk (@elonmusk) 6 luglio 2016

@elonmusk Of course. But an aircraft pilot has to be thoroughly trained and certified for AP use, whereas 1/2 @eddy_jahn— Paolo Attivissimo (@disinformatico) 6 luglio 2016

@elonmusk … a Tesla driver just gets a briefing and clicks on a disclaimer/warning (btw:I love AP and have ordered a Model 3) @eddy_jahn— Paolo Attivissimo (@disinformatico) 6 luglio 2016

@disinformatico @Eddy_Jahn cool, thanks :)— Elon Musk (@elonmusk) 6 luglio 2016

@elonmusk Agreed. But due to difference in pilot vs driver training, perhaps alertness shd be more enforced than hoped for 1/2 @eddy_jahn— Paolo Attivissimo (@disinformatico) 6 luglio 2016

@elonmusk 2/2 E.g., eye-tracking camera checking that driver’s eyes don’t stray from road too long; load cell in seat, etc. @eddy_jahn— Paolo Attivissimo (@disinformatico) 6 luglio 2016

Ci sono inoltre delle differenze enormi fra un pilota automatico moderno (quello di un aereo di linea, per esempio) e l’Autopilot di Tesla.

– Un pilota automatico d’aereo ha un sistema anticollisione automatico che negozia con l'altro veicolo la traiettoria per evitare collisioni (TCAS). L’Autopilot no.

– Un pilota automatico d’aereo è in grado di gestire la rotta per raggiungere la destinazione indicata dal pilota: l’Autopilot non segue la strada indicata dal navigatore, ma semplicemente segue le strisce della corsia della strada sulla quale si trova.

– In cielo non ci sono semafori e la Tesla non riconosce i semafori. Se è in Autopilot, attraverserà un incrocio col rosso.

– Un pilota automatico d'aereo non è cieco a qualunque oggetto si trovi davanti e sopra, ad altezza d'abitacolo.

– A un pilota di aereo di linea non si chiede di accettare come “pilota automatico” un software che è ancora sperimentale.*

*Elon Musk, a ottobre 2015, ha presentato l’Autopilot di Tesla Motors dicendo chiaramente “We still think of it as a public beta, so we want people to be quite careful” e ;ancora oggi l’Autopilot è definito dal costruttore almeno in parte come “software beta”. Inoltre al conducente che sceglie di installarlo viene chiesto di accettare una clausola apposita di responsabilità limitata.

|

| Fonte: Tesla Motors, per Autopilot 7.0 |

Il paragone aeronautico non regge, insomma. Forse dovremmo usare, per il sistema di guida della Tesla, un nome meno ambiguo, come Driver Assistant, Pilot Assistant, Sidekick o qualcos’altro che chiarisca inequivocabilmente il ruolo di supporto al guidatore e non di suo sostituto (fra l’altro, il manuale dell’Autopilot versione 7.1 parla di “Driver Assistance hardware”).

Certo, ci saranno sempre gli stupidi e gli incoscienti che ignoreranno gli avvisi e i nomi, non importa quanto siano chiari (come succede per le cinture di sicurezza, per esempio): ma se un nome meno ingannevole e una campagna promozionale meno sensazionale possono salvare delle vite, secondo me vale la pena di adottarli. Spero che Elon Musk aggiorni il software e i sensori in modo da rendere più difficili comportamenti pericolosi che abusano dell’Autopilot: per esempio con una telecamerina che riconosca i contorni del volto del conducente e si accorga se sta guardando in avanti o no.

Adoro le auto elettriche e le auto autonome/assistite e in particolare le Tesla, tanto da averne ordinata una (la Model 3): inquinano meno e promettono di ridurre gli incidenti e il tempo perso nella guida. Mi dispiacerebbe molto se un nome ingannevole come Autopilot causasse una reazione ostile alle auto di questo tipo, alimentata dall’ignoranza, dal pregiudizio e dalla disattenzione. Presentare questa tecnologia come se fosse matura, quando in realtà non lo è, è pericoloso, perché spinge a una guida eccessivamente fiduciosa e disattenta. Ed è pericoloso in generale per il futuro, soprattutto adesso che si sta discutendo, negli Stati Uniti, la normativa federale sulle auto autonome.

Siamo a una svolta decisiva in un campo tecnologico che ha un potere enorme di trasformare la nostra società: vediamo di affrontarla con prudenza e con informazioni corrette.

2016/07/06

Il Delirio del Giorno: vegani d’assalto

Questo articolo vi arriva gratuitamente e senza pubblicità grazie alle donazioni dei lettori. Se vi piace, potete incoraggiarmi a scrivere ancora (anche con un microabbonamento). Ultimo aggiornamento: 2016/07/06 23:15.

Commento inviato al mio articolo Più batteri che cellule nel corpo umano: ne parlo su Le Scienze:

Non so neanche da che parte cominciare, per cui non comincio nemmeno e lo lascio a voi.

Aggiornamento ore 23:15. Per chi sospetta che si tratti di una trollata: è perfettamente possibile. Se lo è, è ben fatta e fa sorridere; se non lo è, fa riflettere. Capisco la vostra incredulità, e anch’io lo pubblico senza commento proprio per questo, ma se siete increduli perché pensate che nessuno possa essere così delirante, vi invito a visitare un forum di sciachimisti, ufologi, urinoterapeuti o respiriani. Vi ricrederete.

Commento inviato al mio articolo Più batteri che cellule nel corpo umano: ne parlo su Le Scienze:

parli di tutto nel tuo articolo ma quando scriverai un articolo per mettere al bando i mangiacadaveri?

visto che sei tanto scientifico perché non lo scrivi una buona volta che il latte genera autismo e distrugge le ossa dei neonati; che le uova - per le quali vengono torturate e sgozzate milioni di galline - causano la salmonella; che i vaccini vanno aboliti come tutte le medicine perché testate su animali; che la carne non è digeribile dall'organisimo umano e per tale motivo causa ulcere esplosive?

perché non le scrivi queste cose invece di limitarti a parlare di batteri, di cellule umane e di tutto ciò che è permesso dalle lobbies dei macellai e del direttorio scientifico onnovoriano?

fossi in te lo farei.

ora mi rendo conto che devi rispondere a poteri superiori e che non pubblicherai questo mio messaggio ma almeno lo leggerai e potrai riflettere e aprire gli occhi. e magari diventare sensibile ai problemi della natura, diventare vegano, costringere i tuoi figli ad esserlo.

anche se non lo publbicherai confido nella tua saggezza e nel fatto che vedrai la luce.

Non so neanche da che parte cominciare, per cui non comincio nemmeno e lo lascio a voi.

Aggiornamento ore 23:15. Per chi sospetta che si tratti di una trollata: è perfettamente possibile. Se lo è, è ben fatta e fa sorridere; se non lo è, fa riflettere. Capisco la vostra incredulità, e anch’io lo pubblico senza commento proprio per questo, ma se siete increduli perché pensate che nessuno possa essere così delirante, vi invito a visitare un forum di sciachimisti, ufologi, urinoterapeuti o respiriani. Vi ricrederete.

2016/07/02

Come rubare un profilo Facebook senza essere esperti informatici

L’articolo è stato aggiornato dopo la pubblicazione iniziale. Ultimo aggiornamento: 2016/07/05 14:25.

Di solito mi capita di raccontare attacchi informatici basati su vulnerabilità del software usato dagli utenti o su difetti nella sicurezza tecnica dei social network, ma stavolta ho da raccontare un altro approccio, che serve come chiaro promemoria di una cosa fondamentale: siccome noi utenti per i social network siamo soltanto mucche da mungere, a loro della nostra sicurezza non importa praticamente nulla.

Di solito mi capita di raccontare attacchi informatici basati su vulnerabilità del software usato dagli utenti o su difetti nella sicurezza tecnica dei social network, ma stavolta ho da raccontare un altro approccio, che serve come chiaro promemoria di una cosa fondamentale: siccome noi utenti per i social network siamo soltanto mucche da mungere, a loro della nostra sicurezza non importa praticamente nulla.

Se i nostri post intimi, che abbiamo impostato come privati perché sono appunto privati, finiscono per diventare pubblici per errore, rovinando un’amicizia o un amore o una carriera, il problema è soltanto nostro, non loro. Quindi pensateci bene prima di affidare a un social network qualunque informazione personale, perché per rubarla non ci vuole nemmeno una gran competenza informatica. Basta chiedere educatamente.

Lo sa bene Aaron Thompson, un ventitreenne che vive nel Michigan. Il 26 giugno scorso si è accorto che non poteva più accedere al proprio account Facebook e che l’indirizzo di mail e i numeri di telefono associati all’account erano stati cambiati.

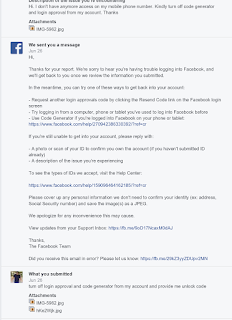

Ha guardato la propria mail e vi ha trovato uno scambio di messaggi fra l’assistenza clienti di Facebook e l’intruso che aveva preso possesso del suo account. L’intruso, per evitare la verifica in due passaggi (autenticazione a due fattori), aveva mandato una richiesta di aiuto all’assistenza clienti di Facebook, dicendo che aveva perso l’accesso al proprio numero di telefonino e chiedendo di disattivare l’approvazione degli accessi e il generatore di codici. La richiesta dell’intruso non proveniva dall’account di posta di Thompson (“the hacker didn't have access to my email or password, they just said they no longer had access to my phone number or email, and facebook allowed them to choose the email to lodge the support ticket from.”).

La risposta automatica dell’assistenza clienti era stata molto semplice: l'interlocutore doveva dimostrare di essere il vero Aaron Thompson mandando una scansione di un documento d’identità.

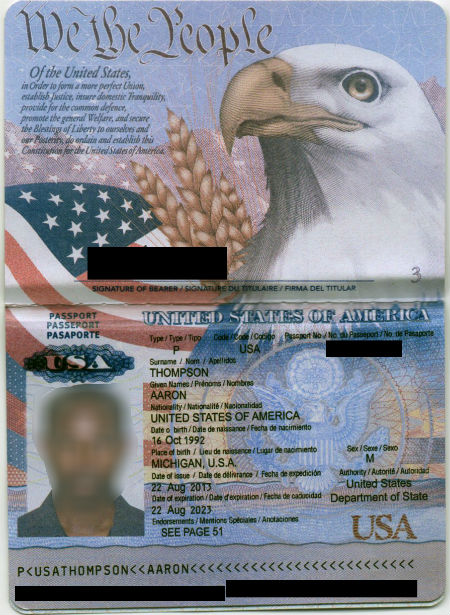

L’intruso aveva risposto mandando questa immagine (alcuni dati sono oscurati nell’immagine qui sotto, ma non lo erano nell’originale inviato a Facebook):

Nessuno dei dati sul passaporto era esatto, a parte il nome, eppure questo è bastato a Facebook per “verificare” l’identità e disattivare tutte le protezioni sull’account di Thompson, cedendone il controllo all’intruso. Facebook poteva confrontare le informazioni nell’account con quelle nel finto passaporto, ma non ha fatto neanche quello.

La motivazione del furto dell’account era probabilmente economica: Thompson ha una serie di pagine Facebook che hanno vari milioni di “Mi piace”, altamente monetizzabili per esempio per uno spammer. Ma l’intruso si è limitato a inviare alcune foto oscene e qualche insulto.

Per riavere il controllo del proprio account su Facebook, Thompson ha dovuto raccontare pubblicamente la propria disavventura su Reddit. La notizia che basta un documento falso per convincere Facebook a disabilitare la verifica in due passaggi, cambiare la mail associata all’account e cambiare la password si è diffusa rapidamente.

Facebook è intervenuta, come racconta Motherboard, e ha ripristinato la situazione, dicendo che “aver accettato questo documento d’identità è stato un errore che ha violato le nostre prassi interne”. Sì, però nel frattempo è successo. Ricordatevelo. E ricordate che è per motivi come questo che non si devono mai dare a sconosciuti scansioni dei propri documenti.

Di solito mi capita di raccontare attacchi informatici basati su vulnerabilità del software usato dagli utenti o su difetti nella sicurezza tecnica dei social network, ma stavolta ho da raccontare un altro approccio, che serve come chiaro promemoria di una cosa fondamentale: siccome noi utenti per i social network siamo soltanto mucche da mungere, a loro della nostra sicurezza non importa praticamente nulla.

Di solito mi capita di raccontare attacchi informatici basati su vulnerabilità del software usato dagli utenti o su difetti nella sicurezza tecnica dei social network, ma stavolta ho da raccontare un altro approccio, che serve come chiaro promemoria di una cosa fondamentale: siccome noi utenti per i social network siamo soltanto mucche da mungere, a loro della nostra sicurezza non importa praticamente nulla.Se i nostri post intimi, che abbiamo impostato come privati perché sono appunto privati, finiscono per diventare pubblici per errore, rovinando un’amicizia o un amore o una carriera, il problema è soltanto nostro, non loro. Quindi pensateci bene prima di affidare a un social network qualunque informazione personale, perché per rubarla non ci vuole nemmeno una gran competenza informatica. Basta chiedere educatamente.

Lo sa bene Aaron Thompson, un ventitreenne che vive nel Michigan. Il 26 giugno scorso si è accorto che non poteva più accedere al proprio account Facebook e che l’indirizzo di mail e i numeri di telefono associati all’account erano stati cambiati.

Ha guardato la propria mail e vi ha trovato uno scambio di messaggi fra l’assistenza clienti di Facebook e l’intruso che aveva preso possesso del suo account. L’intruso, per evitare la verifica in due passaggi (autenticazione a due fattori), aveva mandato una richiesta di aiuto all’assistenza clienti di Facebook, dicendo che aveva perso l’accesso al proprio numero di telefonino e chiedendo di disattivare l’approvazione degli accessi e il generatore di codici. La richiesta dell’intruso non proveniva dall’account di posta di Thompson (“the hacker didn't have access to my email or password, they just said they no longer had access to my phone number or email, and facebook allowed them to choose the email to lodge the support ticket from.”).

La risposta automatica dell’assistenza clienti era stata molto semplice: l'interlocutore doveva dimostrare di essere il vero Aaron Thompson mandando una scansione di un documento d’identità.

L’intruso aveva risposto mandando questa immagine (alcuni dati sono oscurati nell’immagine qui sotto, ma non lo erano nell’originale inviato a Facebook):

Nessuno dei dati sul passaporto era esatto, a parte il nome, eppure questo è bastato a Facebook per “verificare” l’identità e disattivare tutte le protezioni sull’account di Thompson, cedendone il controllo all’intruso. Facebook poteva confrontare le informazioni nell’account con quelle nel finto passaporto, ma non ha fatto neanche quello.

La motivazione del furto dell’account era probabilmente economica: Thompson ha una serie di pagine Facebook che hanno vari milioni di “Mi piace”, altamente monetizzabili per esempio per uno spammer. Ma l’intruso si è limitato a inviare alcune foto oscene e qualche insulto.

Per riavere il controllo del proprio account su Facebook, Thompson ha dovuto raccontare pubblicamente la propria disavventura su Reddit. La notizia che basta un documento falso per convincere Facebook a disabilitare la verifica in due passaggi, cambiare la mail associata all’account e cambiare la password si è diffusa rapidamente.

Facebook è intervenuta, come racconta Motherboard, e ha ripristinato la situazione, dicendo che “aver accettato questo documento d’identità è stato un errore che ha violato le nostre prassi interne”. Sì, però nel frattempo è successo. Ricordatevelo. E ricordate che è per motivi come questo che non si devono mai dare a sconosciuti scansioni dei propri documenti.

Più batteri che cellule nel corpo umano: ne parlo su Le Scienze

Questo articolo vi arriva gratuitamente e senza pubblicità grazie alle donazioni dei lettori. Se vi piace, potete incoraggiarmi a scrivere ancora (anche con un microabbonamento).

Sul numero 575 de Le Scienze, che ora è in edicola e di cui trovate qui il sommario, ho affrontato uno dei luoghi comuni scientifici più diffusi: nel corpo umano ci sono (o ci sarebbero) più batteri che cellule umane, per cui siamo in realtà una sorta di colonia ambulante.

Sul numero 575 de Le Scienze, che ora è in edicola e di cui trovate qui il sommario, ho affrontato uno dei luoghi comuni scientifici più diffusi: nel corpo umano ci sono (o ci sarebbero) più batteri che cellule umane, per cui siamo in realtà una sorta di colonia ambulante.

A completamento dell’articolo, queste sono le principali fonti online che ho consultato. Buona lettura.

– Microbial Ecology of the Gastrointestinal Tract, di Dwayne Savage in Annual Review of Microbiology, 1977

– Power of Ten, di Elio Schaechter e Stanley Maloy

– Revised estimates for the number of human and bacteria cells in the body, di Ron Sender, Shai Fuchs e Ron Milo

Sul numero 575 de Le Scienze, che ora è in edicola e di cui trovate qui il sommario, ho affrontato uno dei luoghi comuni scientifici più diffusi: nel corpo umano ci sono (o ci sarebbero) più batteri che cellule umane, per cui siamo in realtà una sorta di colonia ambulante.

Sul numero 575 de Le Scienze, che ora è in edicola e di cui trovate qui il sommario, ho affrontato uno dei luoghi comuni scientifici più diffusi: nel corpo umano ci sono (o ci sarebbero) più batteri che cellule umane, per cui siamo in realtà una sorta di colonia ambulante.A completamento dell’articolo, queste sono le principali fonti online che ho consultato. Buona lettura.

– Microbial Ecology of the Gastrointestinal Tract, di Dwayne Savage in Annual Review of Microbiology, 1977

– Power of Ten, di Elio Schaechter e Stanley Maloy

– Revised estimates for the number of human and bacteria cells in the body, di Ron Sender, Shai Fuchs e Ron Milo

2016/07/01

Antibufala: il ritorno dell’“avviso salvaprivacy” per Facebook

Questo articolo vi arriva gratuitamente e senza pubblicità grazie alle donazioni dei lettori. Se vi piace, potete incoraggiarmi a scrivere ancora (anche con un microabbonamento).

Ha ripreso a circolare intensamente su Facebook un avviso che per il semplice fatto di essere postato dovrebbe magicamente negare a Facebook il diritto di usare i contenuti pubblicati sul social network dall’utente.

Il messaggio è falso, ma ha comunque una grandissima utilità pubblica: vi permette di riconoscere al volo gli incapaci. Chi lo posta, infatti, non solo massacra l’italiano, ma dimostra anche una totale ignoranza di come funzionano le leggi e i social network.

Come avevo già raccontato quattro anni fa, nel 2012, durante l’epidemia precedente di questa cretinata, chi si iscrive a Facebook sottoscrive un contratto vincolante, che non può essere alterato unilateralmente, né da Facebook, né dall'utente iscritto, senza il consenso di entrambi. Quindi non esiste nessuna formula magica unilaterale. E questa non è una peculiarità di Internet: è una regola di base di tutti i rapporti contrattuali anche nel mondo fisico. Se qualcuno pensa che il mondo funzioni come descritto nell’avviso è meglio saperlo, in modo da non affidargli neanche la gestione degli incarti usati delle caramelle.

Queste condizioni di contratto prevedono che l'utente concede a Facebook “una licenza non esclusiva, trasferibile, che può essere concessa come sottolicenza, libera da royalty e valida in tutto il mondo, che consente l'utilizzo dei Contenuti PI pubblicati su Facebook o in connessione con Facebook ("Licenza PI"). La Licenza PI termina nel momento in cui l'utente elimina il suo account o i Contenuti PI presenti sul suo account, a meno che tali contenuti non siano stati condivisi con terzi e che questi non li abbiano eliminati.”

Ricopio qui sotto il testo della nuova versione in modo che sia facilmente cercabile da chi non ha la triste abitudine di fare copia-incolla-inoltra-a-tutti di qualunque scemenza ricevuta su Facebook:

Consiglio alternativo: per stare sul sicuro, cestinate questo avviso. E per stare ancora più sul sicuro, cestinate anche chi ve l’ha mandato.

Ha ripreso a circolare intensamente su Facebook un avviso che per il semplice fatto di essere postato dovrebbe magicamente negare a Facebook il diritto di usare i contenuti pubblicati sul social network dall’utente.

Il messaggio è falso, ma ha comunque una grandissima utilità pubblica: vi permette di riconoscere al volo gli incapaci. Chi lo posta, infatti, non solo massacra l’italiano, ma dimostra anche una totale ignoranza di come funzionano le leggi e i social network.

Come avevo già raccontato quattro anni fa, nel 2012, durante l’epidemia precedente di questa cretinata, chi si iscrive a Facebook sottoscrive un contratto vincolante, che non può essere alterato unilateralmente, né da Facebook, né dall'utente iscritto, senza il consenso di entrambi. Quindi non esiste nessuna formula magica unilaterale. E questa non è una peculiarità di Internet: è una regola di base di tutti i rapporti contrattuali anche nel mondo fisico. Se qualcuno pensa che il mondo funzioni come descritto nell’avviso è meglio saperlo, in modo da non affidargli neanche la gestione degli incarti usati delle caramelle.

Queste condizioni di contratto prevedono che l'utente concede a Facebook “una licenza non esclusiva, trasferibile, che può essere concessa come sottolicenza, libera da royalty e valida in tutto il mondo, che consente l'utilizzo dei Contenuti PI pubblicati su Facebook o in connessione con Facebook ("Licenza PI"). La Licenza PI termina nel momento in cui l'utente elimina il suo account o i Contenuti PI presenti sul suo account, a meno che tali contenuti non siano stati condivisi con terzi e che questi non li abbiano eliminati.”

Ricopio qui sotto il testo della nuova versione in modo che sia facilmente cercabile da chi non ha la triste abitudine di fare copia-incolla-inoltra-a-tutti di qualunque scemenza ricevuta su Facebook:

Scadenza domani!!!

Tutto quello che avete postato diventa pubblico da domani. Anche i messaggi che sono stati eliminati o le foto non autorizzate. Non costa nulla per un semplice copia e incolla, meglio prevenire che curare. Canale 13 ha parlato del cambiamento nella normativa sulla privacy di Facebook.

Io non do facebook o qualsiasi entità associata a facebook il permesso di usare le mie immagini, informazioni, i messaggi o i post, passato e futuro. Con questa dichiarazione, do avviso a Facebook che è severamente vietato divulgare, copiare, distribuire, trasmettere o prendere qualsiasi altra azione contro di me sulla base di questo profilo e/o il suo contenuto. Il contenuto di questo profilo è privato e le informazioni riservate. La violazione della privacy può essere punita dalla legge (UCC 1-308-1 1 308-103 e lo statuto di Roma). Nota: Facebook è ora un’entità pubblica. Tutti i membri devono pubblicare una nota come questa. Se preferisci, puoi copiare e incollare questa versione. Se non pubblichi una dichiarazione almeno una volta, Sarà tatticamente permettendo l’uso delle tue foto, così come le informazioni contenute negli aggiornamenti di stato di profilo. Non condivido. Copia e incolla per stare sul sicuro.

Consiglio alternativo: per stare sul sicuro, cestinate questo avviso. E per stare ancora più sul sicuro, cestinate anche chi ve l’ha mandato.

Labels:

antibufala,

facebook,

privacy,

social network

Podcast del Disinformatico del 2016/07/01

È disponibile per lo scaricamento il podcast della puntata di oggi del Disinformatico della Radiotelevisione Svizzera. Buon ascolto!

Usate prodotti di sicurezza Symantec? Aggiornateli: sono attaccabilissimi

Grosso imbarazzo in casa Symantec. Venticinque suoi prodotti, venduti per fornire sicurezza agli utenti privati e aziendali, hanno in realtà delle vulnerabilità che espongono i clienti ad attacchi automatici potenzialmente devastanti. L’avviso arriva dal ricercatore di sicurezza informatica Tavis Ormandy: queste falle possono essere sfruttate senza richiedere l’intervento dell’utente e hanno accesso al cuore del sistema informatico proprio perché passano dai suoi sistemi di sicurezza. Per attaccare un utente è sufficiente mandargli un file o un link via mail: la vittima non ha bisogno di aprire il file, e l’attacco è wormable: può diffondersi automaticamente da un computer a un altro.

Ormandy ha dimostrato la vulnerabilità nella maniera più diretta ed eloquente possibile: secondo quanto spiegato in questo tweet, ha inviato a Symantec un attacco (exploit) isolandolo all’interno di un file ZIP protetto da password. Ha incluso la password nella mail. Il server di mail Symantec, sul quale giravano i prodotti Symantec vulnerabili, ha estratto la password dalla mail, ha decifrato il file ZIP, ha letto il codice dell’attacco ed è andato in crash.

Symantec ha pubblicato un avviso di vulnerabilità che elenca 17 suoi prodotti aziendali e otto per uso privato, come Norton AntiVirus, Norton Security, Norton Internet Security, Norton 360, Norton Security for Mac.

Lo stesso avviso elenca anche le versioni aggiornate dei vari software che risolvono le vulnerabilità. Per la maggior parte degli utenti l’aggiornamento dovrebbe essere automatico.

Symantec non è l’unica società di sicurezza informatica a trovarsi nella situazione paradossale di indebolire le difese dei propri clienti invece di aumentarle. Negli ultimi cinque anni, nota Ars Technica, ci sono stati problemi di questo genere con il Comodo, Eset, Kaspersky, FireEye, McAfee, Trend Micro e altri.

Ormandy ha dimostrato la vulnerabilità nella maniera più diretta ed eloquente possibile: secondo quanto spiegato in questo tweet, ha inviato a Symantec un attacco (exploit) isolandolo all’interno di un file ZIP protetto da password. Ha incluso la password nella mail. Il server di mail Symantec, sul quale giravano i prodotti Symantec vulnerabili, ha estratto la password dalla mail, ha decifrato il file ZIP, ha letto il codice dell’attacco ed è andato in crash.

Symantec ha pubblicato un avviso di vulnerabilità che elenca 17 suoi prodotti aziendali e otto per uso privato, come Norton AntiVirus, Norton Security, Norton Internet Security, Norton 360, Norton Security for Mac.

Lo stesso avviso elenca anche le versioni aggiornate dei vari software che risolvono le vulnerabilità. Per la maggior parte degli utenti l’aggiornamento dovrebbe essere automatico.

Symantec non è l’unica società di sicurezza informatica a trovarsi nella situazione paradossale di indebolire le difese dei propri clienti invece di aumentarle. Negli ultimi cinque anni, nota Ars Technica, ci sono stati problemi di questo genere con il Comodo, Eset, Kaspersky, FireEye, McAfee, Trend Micro e altri.

Controlli parentali, terza parte: iPhone, iPad, iPod

Se avete affidato ai figli un dispositivo iOS (iPhone, iPad o iPod) ma volete mettere dei limiti al suo uso, il software preinstallato offre parecchie opzioni. Per prima cosa occorre andare in Impostazioni - Generali - Restrizioni – Abilita restrizioni e impostare un PIN di quattro cifre che protegga le vostre scelte di restrizione.

Fatto questo, potete selezionare quali applicazioni limitare: per esempio, potete bloccare l’accesso a Safari, alla fotocamera, a Siri, al negozio di iTunes. Avete anche la possibilità di vietare l’installazione e disinstallazione di app e gli acquisti in-app. Potete impostare i tipi di contenuti, per esempio limitando la visione dei film, dei programmi TV e altro ancora in base all’età consigliata (la restrizione si applica soltanto ai contenuti legalmente acquistati che supportano questa funzione).

Nella sezione Siti Web potete bloccare l’accesso a tutti i siti, limitare i contenuti per adulti (non è un sistema perfetto, ma ci prova) oppure bloccare l’accesso a siti specifici. In Foto potete regolare l’accesso delle app alle foto memorizzate sul dispositivo e in Localizzazione potete decidere se consentire al minore di attivarla o disattivarla e quali app possono accedere a quest’informazione.

Infine, Partite multigiocatore consente di vietare (appunto) i giochi con più giocatori (per evitare incontri con bulli e molestatori) e Utilizzo dati cellulare permette di vietare l’uso della trasmissione dati per accedere a Internet.

C'è molto altro, descritto in questa pagina di aiuto di Apple in italiano, e il tutto è appunto protetto dal PIN, per cui assicuratevi di tenerlo ben segreto, cambiatelo periodicamente e segnatevelo: se lo dimenticate dovrete azzerare (inizializzare) il dispositivo, col rischio di perdere tutti i dati non salvati altrove.

Se però volete porre limiti di tempo o di orario, vi serve un’applicazione supplementare, come per esempio Curbi. L’app è in prova gratuita per due settimane ma l’uso mensile si paga (6,99 euro / 7 franchi) e bisogna destreggiarsi con l’inglese (non c’è una traduzione in italiano). Se superate questi ostacoli, però, avete la possibilità di impostare appunto orari e tempi di utilizzo, ricevere via mail un rapporto settimanale dettagliato di utilizzo del dispositivo e gestire il dispositivo direttamente dal vostro iPhone, iPad o computer, filtrare la navigazione, sapere quali app sono installate, consentire o meno l’accesso a Internet e altro ancora.

Curbi ha delle particolarità che è meglio conoscere: per esempio, per motivi tecnici sovrastima di una decina di minuti i tempi di utilizzo delle app e segnala app che non conoscete e non avete installato (si tratta del software che visualizza le pubblicità nelle app normali). Inoltre non blocca l'uso di app o giochi che non richiedono l’accesso a Internet, e può essere rimossa (però la si può combinare con le Restrizioni preinstallate per risolvere questi problemi).

Naturalmente tutto questo non vale se l’adorabile creatura ha craccato o fatto il jailbreak del dispositivo: ma in questo caso la soluzione non è tecnologica e ci vuole una sana chiacchierata a tu per tu. I rischi del crack o jailbreak saranno l’argomento della prossima puntata.

Labels:

controllo parentale,

iOS,

iPad,

iPhone,

iPod,

ReteTreRSI

Tesla, primo incidente mortale con “pilota automatico” inserito

L’articolo è stato aggiornato estesamente dopo la pubblicazione iniziale del 2016/07/01. Ultimo aggiornamento: 2016/07/07 21:00.

Il 30 giugno è stato reso noto che a maggio scorso si è verificato negli Stati Uniti, in Florida, il primo incidente mortale a bordo di un’automobile (una Tesla Model S come quella mostrata qui accanto) in modalità di guida assistita.

La notizia ha comprensibilmente scosso non solo i proprietari di auto Tesla ma anche chi segue la rapida evoluzione dei veicoli a guida assistita o autonoma. Prima di saltare a conclusioni affrettate e diffondere dicerie ingannevoli è meglio riassumere i fatti noti a questo punto e correggere alcune storture (o vere e proprie bufale come quelle di Blitz Quotidiano) che stanno iniziando a circolare.

– In Florida, il 7 maggio scorso un autoarticolato commerciale ha impegnato un incrocio che attraversa una superstrada a doppia carreggiata, ponendosi di traverso sulla carreggiata opposta, sulla quale sopraggiungeva un’auto Tesla Model S.

– L’auto, guidata dal quarantenne Joshua Brown, viaggiava con l’Autopilot inserito. L’Autopilot è un sistema di guida assistita (non autonoma) che mantiene l’auto in corsia e frena se rileva un pericolo, ma il conducente resta responsabile della condotta del proprio veicolo.

– Né il conducente né l’Autopilot hanno azionato i freni.

– La Tesla ha colpito la fiancata del rimorchio dell’automezzo commerciale, privo di barriere laterali anti-intrusione, ed è passata sotto il rimorchio stesso. L’abitacolo dell’auto è stato tranciato.

– L’auto ha proseguito la propria corsa uscendo di strada, attraversando una recinzione e finendo in un campo, fermandosi contro un palo dell’elettricità.

– Il conducente è morto sul luogo dell’incidente.

– Il conducente del camion, il sessantaduenne Frank Baressi, accorso sul luogo dove si è fermata l’auto, ha dichiarato di aver udito, ma non visto, quello che ha descritto come “un film di Harry Potter sullo schermo dell’auto”. Tesla Motors ha sottolineato che lo schermo dell’auto non è in grado di riprodurre video. È possibile che si sia trattato di un audiolibro, che il conducente della Tesla ascoltava abitualmente in auto, come si nota nel suo canale Youtube.

– Nella Tesla sono stati trovati un lettore DVD e un laptop, ma entrambi erano spenti (Reuters).

– Il conducente del camion e una testimone affermano che la Tesla viaggiava ad alta velocità: secondo la stima della testimone, oltre 136 km/h.

– Per un destino amaro, Brown era noto nel mondo delle auto a guida assistita perché recentemente aveva pubblicato un video nel quale mostrava come la sua Tesla aveva sterzato autonomamente per evitare un camion che gli stava tagliando la strada nel cambiare corsia in autostrada. Il video era stato segnalato anche da Elon Musk, CEO di Tesla Motors.

– Tesla Motors, in una nota di cordoglio, ha annunciato di aver notificato l’incidente immediatamente alla National Highway Traffic Safety Administration, ente che si occupa della sicurezza stradale, e di aver appreso il 29 giugno che l’NHTSA ha avviato una “valutazione preliminare” sul funzionamento dell’Autopilot durante l’incidente.

– Per chi ha paura che le Tesla e in generale le auto a guida autonoma o assistita siano un pericolo, non va dimenticato che i sistemi di guida assistita sono degli ausilii di guida. La pericolosità di una Tesla dipende dal suo conducente, non dall’auto.

Secondo quanto è emerso fin qui, l’auto stava procedendo lungo una superstrada a doppia carreggiata (divided highway), la US 27, vicino a Williston, in Florida, con l’Autopilot (sistema di guida assistita, non autonoma) inserito. Sulla carreggiata opposta una motrice con rimorchio ha svoltato a sinistra per impegnare un incrocio che attraversa la superstrada; il mezzo pesante ha attraversato la carreggiata sulla quale procedeva la Tesla, presentandosi perpendicolarmente all’auto che stava sopraggiungendo.

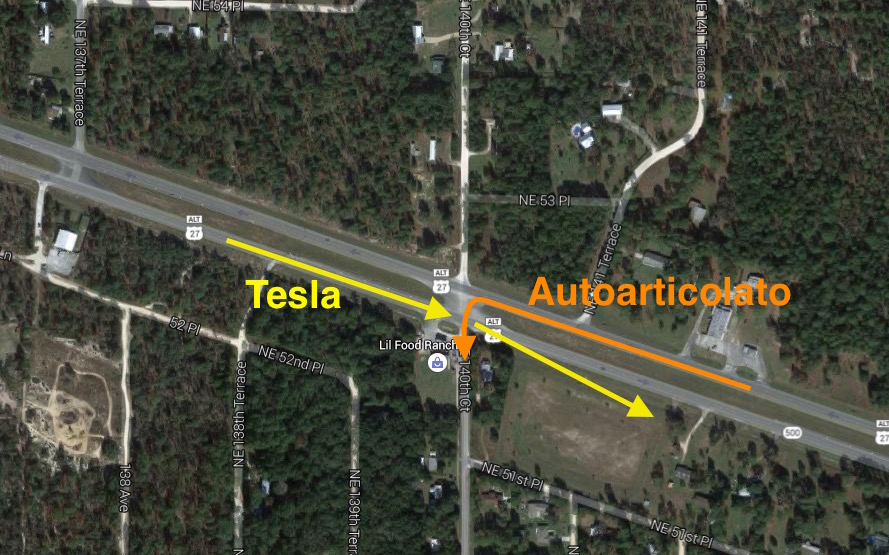

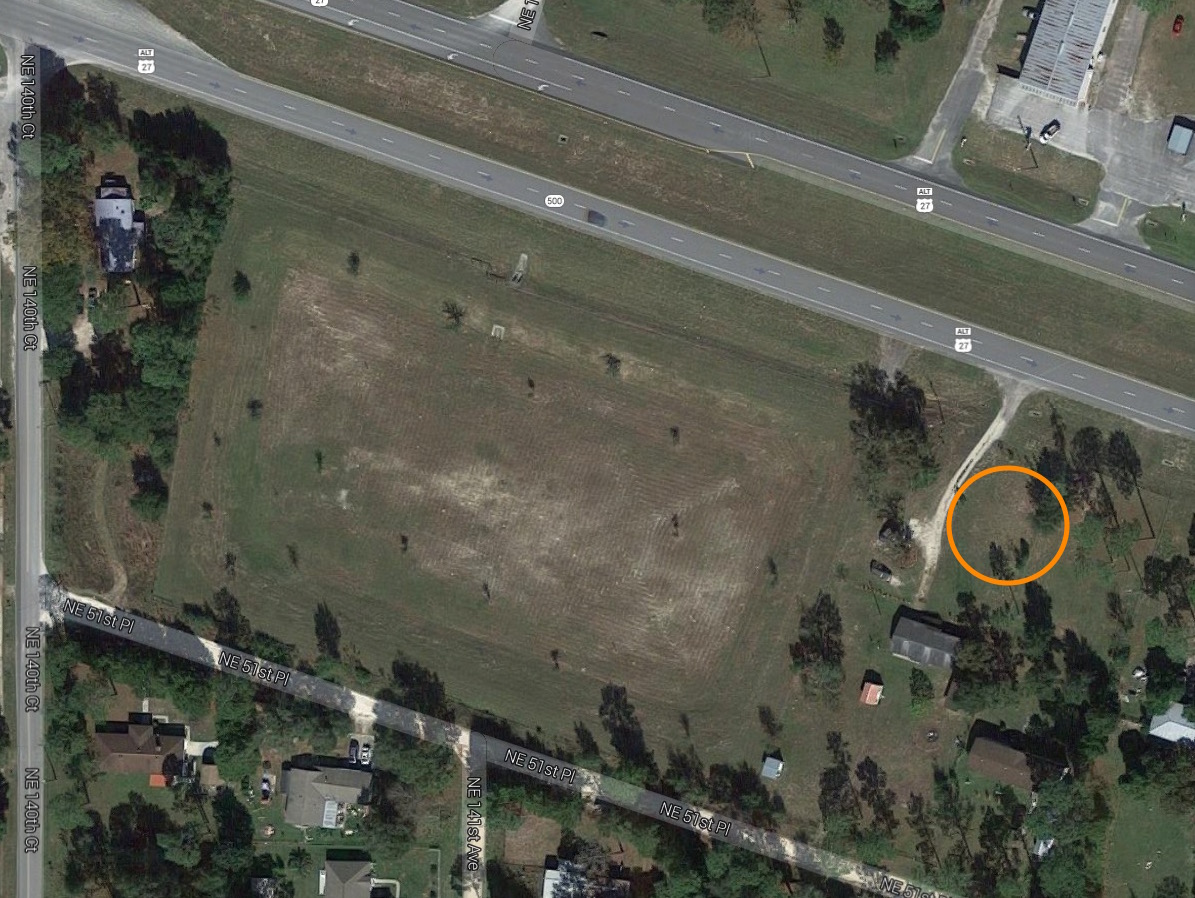

Il luogo è quello mostrato al centro nella cartina qui sotto. Il camion era sulla carreggiata situata a nord e procedeva verso ovest; la Tesla era sulla carreggiata sud e si dirigeva verso est, come mostrato dalle frecce. La strada che attraversa verticalmente la superstrada, al centro dell’immagine, è la NE 140th Court.

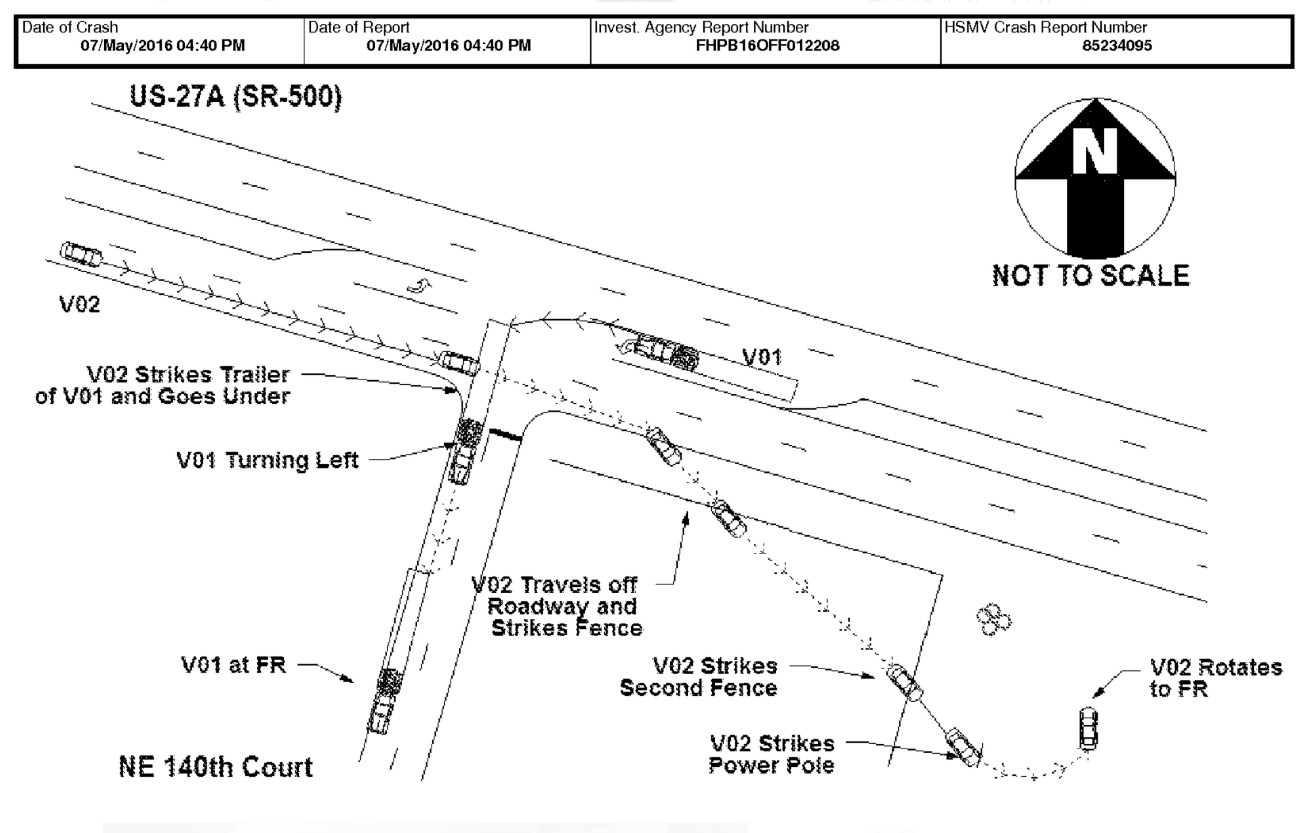

Questo è lo schema pubblicato dalla Florida Highway Patrol dopo la pubblicazione iniziale di questo articolo e diffuso dal New York Times:

Secondo i dati forniti da Tesla Motors né il sistema di guida assistita né il conducente hanno azionato i freni. L’auto si è infilata di traverso sotto il rimorchio del camion, la cui parte inferiore ha tranciato la parte superiore dell’abitacolo dell’auto. Il conducente della Tesla, il quarantenne Joshua Brown, è morto sul luogo dell’incidente. Questo è il suo necrologio.

Il giorno dopo la prima diffusione della notizia, un servizio della rete televisiva ABC (video) ha mostrato le prime immagini dell’auto distrutta. L’auto si è fermata vicino all’abitazione di Bobby Vankavelaar, autore della foto mostrata qui sotto, intervistato dalla ABC nel suddetto servizio.

Questa è una panoramica che ho creato assemblando le immagini del servizio della ABC per capire dove si trovavano i resti dell’auto al momento delle riprese: sono nella zona cerchiata, a circa 270 metri dal punto della collisione, che è nell'angolo superiore sinistro della vista dall’alto offerta da Google Maps. Confrontando il rapporto di polizia con le immagini, sembra che nelle riprese i resti siano ancora nel luogo in cui l’auto si è fermata inizialmente.

Questo è il resoconto della polizia locale a proposito dell’incidente mortale:

I testimoni dell’incidente aggiungono dei dettagli, tutti da verificare.

Secondo quanto dichiarato dal conducente dell’automezzo alla Associated Press, la Tesla “ha trapassato il mio rimorchio così velocemente che non ho visto [il guidatore, Joshua Brown]”. Il camionista ha dichiarato inoltre alla AP di aver visto, dopo l’incidente, che sulla Tesla c’era “Harry Potter sullo schermo della TV” (“playing Harry Potter on the TV screen”), dando l’impressione che si trattasse di un film, ma ha precisato di aver soltanto udito il sonoro. Dato che lo schermo di bordo delle Tesla non può riprodurre file video (può solo mostrare le immagini della telecamera posteriore) se non viene hackerato ad alto livello, è possibile che si sia sbagliato e abbia invece sentito il sonoro di un audiolibro. La passione di Brown per gli audiolibri è documentata.

La polizia ha confermato (Reuters) di aver trovato nell’auto un lettore di DVD portatile, ma inizialmente non ha precisato se era in uso al momento dell’incidente. Il 7 luglio 2016 ha dichiarato che il lettore di DVD e il laptop trovati in auto erano entrambi spenti (Reuters).

Una testimone che stava guidando sulla stessa carreggiata della Tesla ha dichiarato di essere stata sorpassata dalla Tesla mentre lei procedeva a 85 miglia orarie (circa 136 km/h).

Il limite di velocità sulle divided highway in Florida è 65 miglia orarie (circa 105 km/h) (Florida DOT).

La National Highway Traffic Safety Administration, ente statunitense preposto alla sicurezza del traffico, esaminerà l’Autopilot della Tesla per una valutazione preliminare allo scopo di verificare che abbia funzionato “nel modo atteso”, dice Tesla Motors nell’annunciare la notizia con cordoglio, intitolandola A Tragic Loss (“Una perdita tragica”) e precisando che si tratta del primo incidente mortale di cui è a conoscenza su circa 209 milioni di chilometri percorsi dalle Tesla mentre l’Autopilot era inserito. La media statunitense su tutti i veicoli, nota la casa automobilistica, è un incidente mortale ogni 151 milioni di chilometri.

L’NHTSA, nota la BBC, ha dichiarato che “l’apertura della Valutazione Preliminare non deve essere interpretata come un’osservazione che l’Ufficio delle Indagini sui Difetti ritiene che vi sia o non vi sia un difetto nei veicoli in oggetto” (“The opening of the Preliminary Evaluation should not be construed as a finding that the Office of Defects Investigation believes there is either a presence or absence of a defect in the subject vehicles”).

Tesla Motors, sorprendentemente, afferma già ora che “né l’Autopilot né il conducente hanno notato la fiancata bianca del camion contro un cielo fortemente illuminato, per cui il freno non è stato azionato” (“Neither Autopilot nor the driver noticed the white side of the tractor trailer against a brightly lit sky, so the brake was not applied”). Il mancato azionamento del freno è presumibilmente noto a Tesla dalla telemetria inviata dall’auto (tutte le Tesla comunicano costantemente con la sede centrale), ma la certezza con la quale vengono citate come concausa le condizioni d’illuminazione sembra indicare che il mancato rilevamento di ostacoli in queste condizioni è una questione già nota a Tesla Motors. In effetti il manuale della Tesla Model S, a pagina 58-59, dice: “Forward Collision Warning cannot always detect vehicles, bikes, or pedestrians, and you may experience unnecessary, inaccurate, invalid or missed warnings for many reasons, particularly if: [...] Bright light (oncoming headlights or direct sunlight) is interfering with the camera's view”. Non ci sono informazioni in merito nel manuale della versione 7.1 di software della Model S.

L’annuncio di Tesla Motors sottolinea anche che l’Autopilot è sperimentale (è chiaramente indicato più volte che si tratta di software beta ed è l’utente che sceglie di attivarlo), che è “una funzione di assistenza che richiede che si tengano le mani sempre sul volante” e che l’auto ricorda al conducente che deve “mantenere il controllo e la responsabilità” ed essere “pronto a intervenire in ogni momento”. In altre parole, ribadisce una cosa che molti dimenticano: l’Autopilot è soltanto un assistente di guida e non sostituisce il conducente. Le prodezze documentate su Youtube di chi toglie le mani dal volante o addirittura legge il giornale o si siede dietro sono totalmente diseducative oltre che illegali. La Tesla, almeno per ora, non è un’auto a guida autonoma, anche se il nome Autopilot forse spinge molti a pensarlo e ad abusare delle sue funzioni.

Come mai l’Autopilot non ha rilevato l’ostacolo? Questa è probabilmente la domanda che più delle altre sta turbando i proprietari di Tesla e di auto a guida assistita in generale, oltre che le case automobilistiche che producono questi veicoli. La telecamera dell’Autopilot, dice Tesla Motors, è stata ingannata dalle condizioni d’illuminazione, ma la Tesla è dotata anche di un radar: perché non è intervenuto?

Lo spiega Elon Musk, CEO di Tesla Motors in un tweet del 30 giugno: “Radar tunes out what looks like an overhead road sign to avoid false braking events”. In altre parole, il radar ha interpretato la fiancata del rimorchio (un grande rettangolo messo di traverso sopra la carreggiata) come se fosse un cartello stradale sospeso e quindi l’ha ignorato.

Mobileye, l’azienda israeliana che sviluppa alcune delle tecnologie dell’Autopilot, ha commentato l’incidente notando che “l’attuale tecnologia anticollisione, o Automatic Emergency Braking (AEB), è definita come una protezione contro le collisioni posteriori ed è progettata specificamente per questo. Quest’incidente ha riguardato un veicolo che attraversava lateralmente, cosa per la quale i sistemi AEB della generazione corrente non sono progettati per intervenire. I sistemi di Mobileye includeranno capacità di rilevamento di svolta laterale trasversale alla traiettoria [Lateral Turn Across Path] (LTAP) a partire dal 2018 e le classificazioni di sicurezza Euro NCAP la includeranno a partire dal 2020.”

Sulla base dei fatti resi noti fin qui l’incidente sembra essere dovuto più all’attraversamento incauto della superstrada da parte del camion che all’uso di un sistema di guida assistita e non è chiaro, per ora, se l’incidente sarebbe stato evitabile, con o senza Autopilot e simili. È possibile che la velocità sostenuta e la fiducia del conducente dell’auto nell’Autopilot abbiano allungato i suoi tempi di reazione o ridotto l’attenzione, ma per ora si tratta di pura congettura.

Va notato, inoltre, che un incidente del genere difficilmente potrebbe avvenire in Europa, dove gli attraversamenti a raso delle strade a scorrimento veloce sono molto limitati se non inesistenti e dove inoltre le norme impongono ai camion di avere barriere posteriori e laterali che impediscono l’intrusione dell’auto, consentendo alle zone di collassamento programmato dell’automobile di assorbire parte dell’energia d’impatto.

La vera questione da chiarire non è tanto il funzionamento corretto dell’Autopilot, che comunque non è progettato per evitare questo genere di incidenti, dato che la guida è sempre sotto la responsabilità del conducente: è se la guida assistita, come concetto generale indipendente dalla singola marca, abbassi troppo la vigilanza del conducente, finendo per allungare i tempi di reazione perché il conducente non è attento o non interviene perché si aspetta che lo faccia l’auto.

Tesla Motors dice che le statistiche indicano “un miglioramento significativo della sicurezza rispetto alla guida puramente manuale” e anche il presidente del National Transportation Safety Board, Christopher Hart, è dello stesso avviso. Un singolo incidente in regime di guida assistita dopo 209 milioni di chilometri va confrontato con quasi 1,3 milioni di morti l’anno nel mondo a causa di incidenti automobilistici: in media 3287 al giorno. In altre parole, la guida umana causa un 11 settembre ogni giorno. Ma dato che le scelte di sicurezza vengono fatte dagli utenti usando la pancia e non la testa, questo incidente potrebbe avere conseguenze importanti sulla diffusione delle auto a guida semiautomatica e in particolare sull’immagine della Tesla. Al momento dell’annuncio dell’indagine le azioni di Tesla Motors hanno perso il 3%, dice la BBC. Successivamente hanno recuperato.

Fonti: Electrek, Ars Technica, Teslarati, BBC, The Register.

|

| Una Tesla Model S simile a quella dell’incidente. |

La notizia ha comprensibilmente scosso non solo i proprietari di auto Tesla ma anche chi segue la rapida evoluzione dei veicoli a guida assistita o autonoma. Prima di saltare a conclusioni affrettate e diffondere dicerie ingannevoli è meglio riassumere i fatti noti a questo punto e correggere alcune storture (o vere e proprie bufale come quelle di Blitz Quotidiano) che stanno iniziando a circolare.

Per chi ha fretta

|

| Joshua Brown con la sua Tesla (NYT). |

– L’auto, guidata dal quarantenne Joshua Brown, viaggiava con l’Autopilot inserito. L’Autopilot è un sistema di guida assistita (non autonoma) che mantiene l’auto in corsia e frena se rileva un pericolo, ma il conducente resta responsabile della condotta del proprio veicolo.

– Né il conducente né l’Autopilot hanno azionato i freni.

– La Tesla ha colpito la fiancata del rimorchio dell’automezzo commerciale, privo di barriere laterali anti-intrusione, ed è passata sotto il rimorchio stesso. L’abitacolo dell’auto è stato tranciato.

– L’auto ha proseguito la propria corsa uscendo di strada, attraversando una recinzione e finendo in un campo, fermandosi contro un palo dell’elettricità.

– Il conducente è morto sul luogo dell’incidente.

– Il conducente del camion, il sessantaduenne Frank Baressi, accorso sul luogo dove si è fermata l’auto, ha dichiarato di aver udito, ma non visto, quello che ha descritto come “un film di Harry Potter sullo schermo dell’auto”. Tesla Motors ha sottolineato che lo schermo dell’auto non è in grado di riprodurre video. È possibile che si sia trattato di un audiolibro, che il conducente della Tesla ascoltava abitualmente in auto, come si nota nel suo canale Youtube.

– Nella Tesla sono stati trovati un lettore DVD e un laptop, ma entrambi erano spenti (Reuters).

– Il conducente del camion e una testimone affermano che la Tesla viaggiava ad alta velocità: secondo la stima della testimone, oltre 136 km/h.

– Per un destino amaro, Brown era noto nel mondo delle auto a guida assistita perché recentemente aveva pubblicato un video nel quale mostrava come la sua Tesla aveva sterzato autonomamente per evitare un camion che gli stava tagliando la strada nel cambiare corsia in autostrada. Il video era stato segnalato anche da Elon Musk, CEO di Tesla Motors.

– Tesla Motors, in una nota di cordoglio, ha annunciato di aver notificato l’incidente immediatamente alla National Highway Traffic Safety Administration, ente che si occupa della sicurezza stradale, e di aver appreso il 29 giugno che l’NHTSA ha avviato una “valutazione preliminare” sul funzionamento dell’Autopilot durante l’incidente.

– Per chi ha paura che le Tesla e in generale le auto a guida autonoma o assistita siano un pericolo, non va dimenticato che i sistemi di guida assistita sono degli ausilii di guida. La pericolosità di una Tesla dipende dal suo conducente, non dall’auto.

I fatti in dettaglio

Secondo quanto è emerso fin qui, l’auto stava procedendo lungo una superstrada a doppia carreggiata (divided highway), la US 27, vicino a Williston, in Florida, con l’Autopilot (sistema di guida assistita, non autonoma) inserito. Sulla carreggiata opposta una motrice con rimorchio ha svoltato a sinistra per impegnare un incrocio che attraversa la superstrada; il mezzo pesante ha attraversato la carreggiata sulla quale procedeva la Tesla, presentandosi perpendicolarmente all’auto che stava sopraggiungendo.

Il luogo è quello mostrato al centro nella cartina qui sotto. Il camion era sulla carreggiata situata a nord e procedeva verso ovest; la Tesla era sulla carreggiata sud e si dirigeva verso est, come mostrato dalle frecce. La strada che attraversa verticalmente la superstrada, al centro dell’immagine, è la NE 140th Court.

Questo è lo schema pubblicato dalla Florida Highway Patrol dopo la pubblicazione iniziale di questo articolo e diffuso dal New York Times:

Secondo i dati forniti da Tesla Motors né il sistema di guida assistita né il conducente hanno azionato i freni. L’auto si è infilata di traverso sotto il rimorchio del camion, la cui parte inferiore ha tranciato la parte superiore dell’abitacolo dell’auto. Il conducente della Tesla, il quarantenne Joshua Brown, è morto sul luogo dell’incidente. Questo è il suo necrologio.

Il giorno dopo la prima diffusione della notizia, un servizio della rete televisiva ABC (video) ha mostrato le prime immagini dell’auto distrutta. L’auto si è fermata vicino all’abitazione di Bobby Vankavelaar, autore della foto mostrata qui sotto, intervistato dalla ABC nel suddetto servizio.

|

| Credit: Bobby Vankavelaar / ABC |

Questa è una panoramica che ho creato assemblando le immagini del servizio della ABC per capire dove si trovavano i resti dell’auto al momento delle riprese: sono nella zona cerchiata, a circa 270 metri dal punto della collisione, che è nell'angolo superiore sinistro della vista dall’alto offerta da Google Maps. Confrontando il rapporto di polizia con le immagini, sembra che nelle riprese i resti siano ancora nel luogo in cui l’auto si è fermata inizialmente.

Questo è il resoconto della polizia locale a proposito dell’incidente mortale:

...on May 7 at 3:40 p.m. on U.S. 27 near the BP Station west of Williston, a 45-year-old Ohio man was killed when he drove under the trailer of an 18-wheel semi. The top of Joshua Brown’s 2015 Tesla Model S vehicle was torn off by the force of the collision. The truck driver, Frank Baressi, 62, Tampa was not injured in the crash. The FHP said the tractor-trailer was traveling west on US 27A in the left turn lane toward 140th Court. Brown’s car was headed east in the outside lane of U.S. 27A. When the truck made a left turn onto NE 140th Court in front of the car, the car’s roof struck the underside of the trailer as it passed under the trailer. The car continued to travel east on U.S. 27A until it left the roadway on the south shoulder and struck a fence. The car smashed through two fences and struck a power pole. The car rotated counter-clockwise while sliding to its final resting place about 100 feet south of the highway. Brown died at the scene. Charges are pending.

I testimoni dell’incidente aggiungono dei dettagli, tutti da verificare.

Secondo quanto dichiarato dal conducente dell’automezzo alla Associated Press, la Tesla “ha trapassato il mio rimorchio così velocemente che non ho visto [il guidatore, Joshua Brown]”. Il camionista ha dichiarato inoltre alla AP di aver visto, dopo l’incidente, che sulla Tesla c’era “Harry Potter sullo schermo della TV” (“playing Harry Potter on the TV screen”), dando l’impressione che si trattasse di un film, ma ha precisato di aver soltanto udito il sonoro. Dato che lo schermo di bordo delle Tesla non può riprodurre file video (può solo mostrare le immagini della telecamera posteriore) se non viene hackerato ad alto livello, è possibile che si sia sbagliato e abbia invece sentito il sonoro di un audiolibro. La passione di Brown per gli audiolibri è documentata.

La polizia ha confermato (Reuters) di aver trovato nell’auto un lettore di DVD portatile, ma inizialmente non ha precisato se era in uso al momento dell’incidente. Il 7 luglio 2016 ha dichiarato che il lettore di DVD e il laptop trovati in auto erano entrambi spenti (Reuters).

Una testimone che stava guidando sulla stessa carreggiata della Tesla ha dichiarato di essere stata sorpassata dalla Tesla mentre lei procedeva a 85 miglia orarie (circa 136 km/h).

Il limite di velocità sulle divided highway in Florida è 65 miglia orarie (circa 105 km/h) (Florida DOT).

La National Highway Traffic Safety Administration, ente statunitense preposto alla sicurezza del traffico, esaminerà l’Autopilot della Tesla per una valutazione preliminare allo scopo di verificare che abbia funzionato “nel modo atteso”, dice Tesla Motors nell’annunciare la notizia con cordoglio, intitolandola A Tragic Loss (“Una perdita tragica”) e precisando che si tratta del primo incidente mortale di cui è a conoscenza su circa 209 milioni di chilometri percorsi dalle Tesla mentre l’Autopilot era inserito. La media statunitense su tutti i veicoli, nota la casa automobilistica, è un incidente mortale ogni 151 milioni di chilometri.

L’NHTSA, nota la BBC, ha dichiarato che “l’apertura della Valutazione Preliminare non deve essere interpretata come un’osservazione che l’Ufficio delle Indagini sui Difetti ritiene che vi sia o non vi sia un difetto nei veicoli in oggetto” (“The opening of the Preliminary Evaluation should not be construed as a finding that the Office of Defects Investigation believes there is either a presence or absence of a defect in the subject vehicles”).

Tesla Motors, sorprendentemente, afferma già ora che “né l’Autopilot né il conducente hanno notato la fiancata bianca del camion contro un cielo fortemente illuminato, per cui il freno non è stato azionato” (“Neither Autopilot nor the driver noticed the white side of the tractor trailer against a brightly lit sky, so the brake was not applied”). Il mancato azionamento del freno è presumibilmente noto a Tesla dalla telemetria inviata dall’auto (tutte le Tesla comunicano costantemente con la sede centrale), ma la certezza con la quale vengono citate come concausa le condizioni d’illuminazione sembra indicare che il mancato rilevamento di ostacoli in queste condizioni è una questione già nota a Tesla Motors. In effetti il manuale della Tesla Model S, a pagina 58-59, dice: “Forward Collision Warning cannot always detect vehicles, bikes, or pedestrians, and you may experience unnecessary, inaccurate, invalid or missed warnings for many reasons, particularly if: [...] Bright light (oncoming headlights or direct sunlight) is interfering with the camera's view”. Non ci sono informazioni in merito nel manuale della versione 7.1 di software della Model S.

L’annuncio di Tesla Motors sottolinea anche che l’Autopilot è sperimentale (è chiaramente indicato più volte che si tratta di software beta ed è l’utente che sceglie di attivarlo), che è “una funzione di assistenza che richiede che si tengano le mani sempre sul volante” e che l’auto ricorda al conducente che deve “mantenere il controllo e la responsabilità” ed essere “pronto a intervenire in ogni momento”. In altre parole, ribadisce una cosa che molti dimenticano: l’Autopilot è soltanto un assistente di guida e non sostituisce il conducente. Le prodezze documentate su Youtube di chi toglie le mani dal volante o addirittura legge il giornale o si siede dietro sono totalmente diseducative oltre che illegali. La Tesla, almeno per ora, non è un’auto a guida autonoma, anche se il nome Autopilot forse spinge molti a pensarlo e ad abusare delle sue funzioni.

Precisazioni di Elon Musk e Mobileye

Come mai l’Autopilot non ha rilevato l’ostacolo? Questa è probabilmente la domanda che più delle altre sta turbando i proprietari di Tesla e di auto a guida assistita in generale, oltre che le case automobilistiche che producono questi veicoli. La telecamera dell’Autopilot, dice Tesla Motors, è stata ingannata dalle condizioni d’illuminazione, ma la Tesla è dotata anche di un radar: perché non è intervenuto?

Lo spiega Elon Musk, CEO di Tesla Motors in un tweet del 30 giugno: “Radar tunes out what looks like an overhead road sign to avoid false braking events”. In altre parole, il radar ha interpretato la fiancata del rimorchio (un grande rettangolo messo di traverso sopra la carreggiata) come se fosse un cartello stradale sospeso e quindi l’ha ignorato.

Mobileye, l’azienda israeliana che sviluppa alcune delle tecnologie dell’Autopilot, ha commentato l’incidente notando che “l’attuale tecnologia anticollisione, o Automatic Emergency Braking (AEB), è definita come una protezione contro le collisioni posteriori ed è progettata specificamente per questo. Quest’incidente ha riguardato un veicolo che attraversava lateralmente, cosa per la quale i sistemi AEB della generazione corrente non sono progettati per intervenire. I sistemi di Mobileye includeranno capacità di rilevamento di svolta laterale trasversale alla traiettoria [Lateral Turn Across Path] (LTAP) a partire dal 2018 e le classificazioni di sicurezza Euro NCAP la includeranno a partire dal 2020.”

Considerazioni generali

Sulla base dei fatti resi noti fin qui l’incidente sembra essere dovuto più all’attraversamento incauto della superstrada da parte del camion che all’uso di un sistema di guida assistita e non è chiaro, per ora, se l’incidente sarebbe stato evitabile, con o senza Autopilot e simili. È possibile che la velocità sostenuta e la fiducia del conducente dell’auto nell’Autopilot abbiano allungato i suoi tempi di reazione o ridotto l’attenzione, ma per ora si tratta di pura congettura.

Va notato, inoltre, che un incidente del genere difficilmente potrebbe avvenire in Europa, dove gli attraversamenti a raso delle strade a scorrimento veloce sono molto limitati se non inesistenti e dove inoltre le norme impongono ai camion di avere barriere posteriori e laterali che impediscono l’intrusione dell’auto, consentendo alle zone di collassamento programmato dell’automobile di assorbire parte dell’energia d’impatto.

La vera questione da chiarire non è tanto il funzionamento corretto dell’Autopilot, che comunque non è progettato per evitare questo genere di incidenti, dato che la guida è sempre sotto la responsabilità del conducente: è se la guida assistita, come concetto generale indipendente dalla singola marca, abbassi troppo la vigilanza del conducente, finendo per allungare i tempi di reazione perché il conducente non è attento o non interviene perché si aspetta che lo faccia l’auto.

Tesla Motors dice che le statistiche indicano “un miglioramento significativo della sicurezza rispetto alla guida puramente manuale” e anche il presidente del National Transportation Safety Board, Christopher Hart, è dello stesso avviso. Un singolo incidente in regime di guida assistita dopo 209 milioni di chilometri va confrontato con quasi 1,3 milioni di morti l’anno nel mondo a causa di incidenti automobilistici: in media 3287 al giorno. In altre parole, la guida umana causa un 11 settembre ogni giorno. Ma dato che le scelte di sicurezza vengono fatte dagli utenti usando la pancia e non la testa, questo incidente potrebbe avere conseguenze importanti sulla diffusione delle auto a guida semiautomatica e in particolare sull’immagine della Tesla. Al momento dell’annuncio dell’indagine le azioni di Tesla Motors hanno perso il 3%, dice la BBC. Successivamente hanno recuperato.

Fonti: Electrek, Ars Technica, Teslarati, BBC, The Register.

Iscriviti a:

Post (Atom)