È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate presso www.rsi.ch/ildisinformatico (link diretto) e qui sotto.

Le puntate del Disinformatico sono ascoltabili anche tramite feed RSS, iTunes, Google Podcasts e Spotify.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

---

[CLIP: Gente che grida perché crede di aver visto fantasmi - da YouTube]

Su TikTok e YouTube ci sono molti video che mostrano persone che percorrono lentamente una strada interna di un cimitero a bordo di una Tesla e si spaventano perché l’auto segnala sul proprio schermo che vicino al veicolo c’è qualcuno che loro non vedono. Di solito questi video sono accompagnati da musica inquietante e da reazioni esagerate, che non si sa se siano sincere o recitate. Ma il tema è sempre lo stesso: le Tesla vedono i fantasmi. Perlomeno secondo chi pubblica questi video.

[CLIP: Persone che gridano perché credono di aver visto fantasmi]

Questa è la storia di come un TikTok Challenge in salsa paranormale ha creato un mito, spaventa gli animi sensibili ed è un’occasione per capire meglio come funziona realmente il riconoscimento delle immagini tramite intelligenza artificiale, perché sbaglia e vede “fantasmi”, e soprattutto perché è importante essere consapevoli che questi suoi sbagli possono diventare realmente pericolosi.

Benvenuti alla puntata del 19 maggio 2023 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Prima di tutto, è importante chiarire che i video di “fantasmi” avvistati dalle auto Tesla mostrano un fenomeno reale, nel senso che è davvero possibile che sullo schermo principale di queste automobili, quello che mostra l’ambiente intorno al veicolo, compaiano sagome di persone che non esistono. Ma non c’è nulla di ultraterreno o paranormale: si tratta di un effetto frequente delle tecnologie usate da questo tipo di auto.

Le auto di Tesla e di molte altre marche sono dotate di telecamere perimetrali che guardano in tutte le direzioni. Le immagini di queste telecamere vengono inviate al computer di bordo, che le analizza e, nel caso di Tesla, mostra sullo schermo in cabina un’animazione tridimensionale schematica degli oggetti che sono stati identificati da questa analisi: le strisce di delimitazione della corsia, i cartelli stradali, i semafori, i veicoli e i pedoni.

Questa animazione è basata sul riconoscimento automatico delle immagini. Il software di bordo è stato addestrato a riconoscere gli oggetti mostrandogli moltissime fotografie di vari oggetti e indicandogli il tipo di oggetto mostrato, esattamente come si fa con un bambino per insegnargli a riconoscere le cose che gli stanno intorno. Ma le somiglianze finiscono qui, perché il software usa un sistema molto differente da quello umano per identificare gli oggetti.

La differenza fondamentale, semplificando molto, è che il software si basa esclusivamente sulle immagini, cioè sulle forme e i colori, mentre una persona usa anche il contesto, ossia informazioni come la distanza, il tipo di ambiente in cui si trova, le regole fondamentali della realtà: per esempio un camion non può fluttuare a mezz’aria, gli oggetti non appaiono e scompaiono di colpo e una persona non può camminare a cento chilometri l’ora.

È questa mancanza di contesto a causare l’apparizione dei fantasmi sullo schermo delle Tesla: il software sbaglia a interpretare l’immagine che gli è stata inviata dalle telecamere, non ha modo di “rendersi conto” del proprio errore valutando la plausibilità della sua interpretazione, e così mostra sullo schermo il risultato del suo sbaglio. L’automobile non sta rivelando cose che i nostri occhi umani non possono vedere; le sue telecamere non stanno ricevendo emanazioni dall’aldilà. I presunti “fantasmi” sono semplicemente errori momentanei di interpretazione automatica delle immagini.

[CLIP da Ghostbusters]

Anche le persone che credono alla natura ultraterrena di questi avvistamenti commettono a loro volta un errore di interpretazione, a un livello molto differente, perché non sanno come funzionano questi software. Ovviamente, se il contesto è un cimitero, magari di notte, la fantasia galoppa e l’unica giustificazione che viene in mente a chi non conosce queste tecnologie è la presenza di un fantasma.

Però tutto questo non spiega come faccia un computer a sbagliare così clamorosamente, per esempio riconoscendo una sagoma umana in un’immagine in cui non c’è nessuno ma si vedono solo prati, fiori e qualche lapide. Scambiare una statua per una persona avrebbe senso, per esempio, ma nei video dei presunti fantasmi si vede chiaramente che intorno all’auto non ci sono oggetti di forma umana. Come fa un computer a sbagliare così tanto?

Confondere sedie a dondolo e occhiali

Alexander Turner, assistente universitario presso la facoltà di scienze informatiche all’Università di Nottingham, nel Regno Unito, spiega in un video della serie Computerphile su YouTube che il riconoscimento delle immagini fatto oggi dai computer in sostanza assegna a ciascuna immagine un valore di probabilità di identificazione.

[CLIP: dal video di Turner per Computerphile]

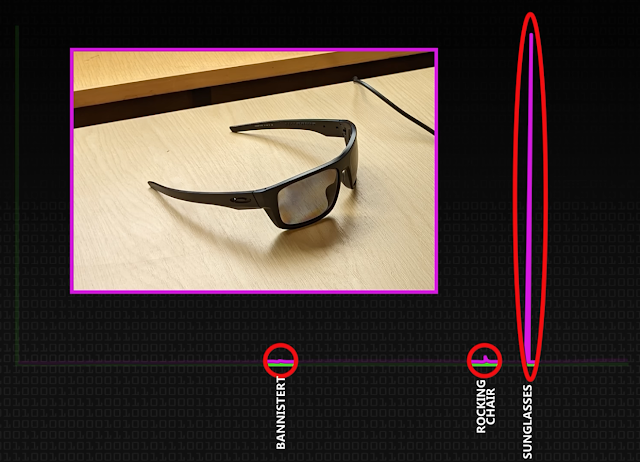

Per esempio, se si mostra a uno di questi software una foto di un paio di occhiali, il software risponde che rientra nella categoria “occhiali” con una probabilità del 93%, ma non esclude che si tratti di una sedia a dondolo o di un corrimano di una scala, con probabilità però molto più basse.

Questo è il meglio che riesce a fare: bisogna ricordare che il software non “sa” cosa siano gli occhiali o le sedie a dondolo, ma si sta basando esclusivamente sulle forme e sui colori presenti nell’immagine e li sta confrontando con i milioni di campioni di immagini di occhiali, sedie a dondolo e corrimano sui quali è stato addestrato, misurando quanto l’immagine proposta si avvicini a una delle categorie che conosce e poi scegliendo la categoria che ha la maggiore probabilità di corrispondenza, cioè di somiglianza. Tutto qui.

Questo approccio probabilistico, così lontano dalla certezza umana, porta a una vulnerabilità inaspettata di questi sistemi di riconoscimento delle immagini. Come spiega Alexander Turner, di solito il software assegna una probabilità molto alta a una singola categoria e alcune probabilità molto basse ad altre categorie, ma è possibile influenzare fortemente queste assegnazioni con un trucco: basta cambiare qualche pixel a caso dell’immagine e vedere se la probabilità di identificazione corretta aumenta o diminuisce di qualche decimale. Se diminuisce, si mantiene quel pixel cambiato e si prova a cambiarne anche un altro, e così via, ripetutamente, tenendo i pixel alterati che fanno scendere la probabilità di identificazione esatta e fanno salire quella di identificazione errata.

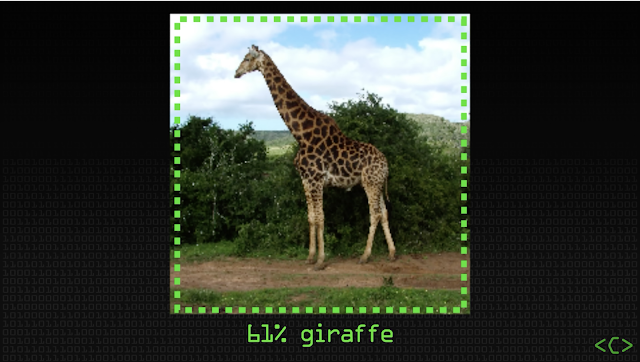

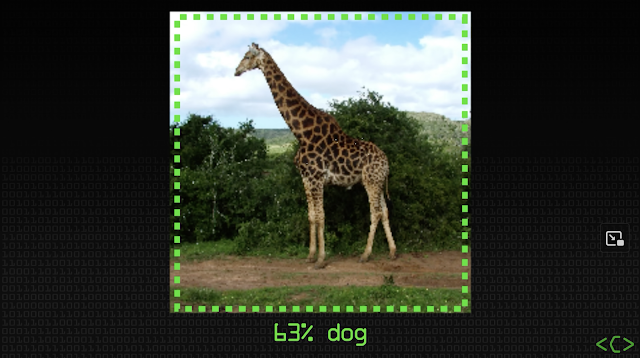

La cosa sorprendente di questa tecnica è che i pixel cambiati che alterano il riconoscimento non hanno niente a che vedere con l’oggetto nell’immagine ma sono una nuvola di punti colorati apparentemente casuali. Per esempio, si può prendere una foto di una giraffa, che il software identifica correttamente come giraffa al 61%, cambiare alcuni pixel qua e là, magari anche solo sullo sfondo, e ottenere che il software identifichi l’immagine come cane al 63%. Ai nostri occhi la foto mostra ancora molto chiaramente una giraffa, ma agli occhi virtuali del software quella giraffa è ora altrettanto chiaramente un cane.

Turner prosegue la sua dimostrazione con una foto di un telecomando per televisori su uno sfondo bianco, che viene riconosciuta correttamente dal software: ma spargendo opportunamente dei pixel colorati sull’immagine, il software dichiara che si tratta di una tazza, e assegna a questa identificazione addirittura il 99% di probabilità. Il ricercatore ripete l’esperimento con altri pixel sparsi e il software dice con la stessa certezza che si tratta di una tastiera, di una busta, di una pallina da golf o di una fotocopiatrice. Eppure noi, guardando le immagini alterate, continuiamo a vedere chiaramente che si tratta sempre di un telecomando.

La conclusione di questo esperimento è che non solo i computer riconoscono gli oggetti in maniera molto differente da noi, ma esistono delle immagini che li confondono completamente anche se ai nostri occhi non sono ambigue e sembrano semplicemente foto di un oggetto sporcate da qualche puntino disposto a caso. Noi prendiamo lucciole per lanterne, loro scambiano telecomandi per palline da golf.

[CLIP da video di presunti fantasmi visti dalle Tesla]

Nel caso dei presunti fantasmi avvistati dalle Tesla, è probabile che una specifica inquadratura di un particolare punto del prato di un cimitero contenga momentaneamente un insieme di pixel sparsi qua e là, come quelli usati nell’esperimento di Turner, che al nostro sguardo non spiccano affatto ma che per il software spostano la probabilità di identificazione verso la categoria “persona”.

Bisogna ricordare, infatti, che non è necessario che l’immagine sia riconosciuta con il 100% di certezza: è sufficiente che il software assegni alla categoria “persona” una probabilità anche solo leggermente più alta rispetto a tutte le altre categorie. E così sullo schermo comparirà improvvisamente e per un istante la sagoma di un essere umano.

Mistero risolto, insomma. Ma un fantasma, comunque, in questa storia c’è lo stesso.

Il fantasma in autostrada

Gli avvistamenti di presunti fantasmi nei cimiteri a causa di errori del software di riconoscimento delle immagini ovviamente fanno parecchia impressione e generano video molto virali, ma c’è un altro tipo di avvistamento fantasma da parte delle automobili dotate di telecamere che è reale ed è importante conoscerlo perché ha conseguenze molto concrete.

Le telecamere di questi veicoli vengono usate per l’assistenza alla guida, per esempio per il mantenimento di corsia, per la lettura dei limiti di velocità e per l’identificazione degli ostacoli. L’auto adatta la propria velocità in base alla segnaletica e alla presenza di barriere, veicoli o altri oggetti lungo la strada. Ma se il software di riconoscimento delle immagini sbaglia ad assegnare categorie agli oggetti che vede, le conseguenze possono essere pericolose.

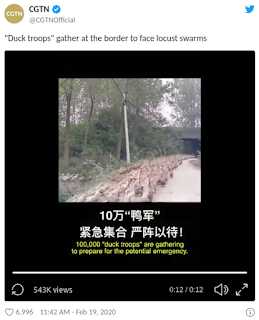

Questi sbagli possono essere spesso comprensibili e anticipabili da parte del conducente, come in un video molto popolare che circola su Twitter e mostra una Tesla che sbaglia a identificare una carrozza che le sta davanti e la mostra come camion, come furgone, poi di nuovo come autoarticolato ma rivolto in senso contrario alla direzione di marcia, e infine aggiunge un inesistente essere umano che cammina in mezzo alla strada. Fortunatamente tutta la scena avviene a bassissima velocità e in modalità di guida manuale; ma se fosse stata attiva la guida assistita, come avrebbe reagito l’auto a quel pedone fantasma?

La Tesla non riconosce una carrozza.. Deficenza artificiale.. 🙄😒 pic.twitter.com/e0WN8HEbXc

— Mauro Granati (@granati_mauro) May 13, 2023

In altre circostanze, invece, lo sbaglio del software può essere completamente incomprensibile e imprevedibile. Se il riconoscimento delle immagini del sistema di assistenza alla guida identifica erroneamente che c’è un ostacolo che in realtà non esiste, e lo fa perché in quell’istante l’immagine inviata dalle telecamere contiene per caso dei pixel che spostano la probabilità di identificazione verso la categoria “ostacolo”, l’auto potrebbe frenare di colpo senza motivo apparente. È quello che gli utenti di questi veicoli chiamano phantom braking, ossia “frenata fantasma”, e se avviene nel traffico può aumentare la probabilità di tamponamenti, perché il conducente del veicolo che sta dietro non si aspetta che l’auto che ha davanti freni improvvisamente e senza motivo quando la strada è libera. Le versioni più recenti dei software di guida assistita hanno ridotto questo fenomeno, ma non è ancora scomparso del tutto.

Si può anche immaginare uno scenario in cui vengono create intenzionalmente situazioni che sembrano innocue ai nostri occhi ma producono errori nei sistemi di riconoscimento delle immagini. Per esempio, per le auto a guida assistita è facile pensare a immagini speciali, applicate al retro di furgoni o camion o cartelli stradali, oppure sul manto stradale, che hanno un aspetto normale ma contengono uno schema di pixel apparentemente casuali che forza i veicoli a frenare, accelerare o cambiare corsia, con intenti ostili oppure protettivi.

Uscendo dal settore automobilistico, sono già in vendita indumenti che hanno colorazioni e forme che all’osservatore umano sembrano prive di significato ma che mettono in crisi i sistemi di riconoscimento facciale delle telecamere di sorveglianza. In campo medico, l’uso crescente di sistemi di riconoscimento automatico delle immagini per la diagnosi può portare a sviste devastanti se il software non ha un approccio prudente, ossia genera falsi positivi invece di falsi negativi, e se il medico non conosce e non considera queste debolezze del software.

Insomma, non vi angosciate: le anime dei defunti non hanno deciso di rendersi visibili solo a chi ha un’automobile di una specifica marca. Almeno per ora.

[CLIP: Risata di Vincent Price da Thriller di Michael Jackson]

Fonti aggiuntive: Makeuseof.com, Ricoh, Carscoops.com, Science Times, IFLScience.